02.10.2025 - Fachartikel

Was ist Tokenisierung in der KI? Einfach erklärt

Künstliche Intelligenz und insbesondere Sprachmodelle wie ChatGPT faszinieren durch ihre Fähigkeit, Texte fast wie ein Mensch zu verstehen und zu erzeugen. Doch wie schaffen es diese Systeme überhaupt, unsere Sprache zu verarbeiten, die voller Mehrdeutigkeiten, Dialekte, Wortneuschöpfungen und Sonderzeichen steckt? Die Antwort liegt in einem unscheinbaren, aber entscheidenden Schritt: die Tokenisierung. Sie verwandelt Texte in kleine, für Maschinen verständliche Einheiten – die Token.

Inhalt

Was bedeutet Tokenisierung?

Im ersten Schritt der Textverarbeitung wird die Nutzereingabe tokenisiert. Dabei zerlegt die KI den Eingabetext in kleinere Einheiten – die sogenannten Token.

Ein Token kann sein:

ein einzelnes Zeichen (z. B. „a“, „?“),

ein Wortbestandteil (z. B. „Pro-“ oder „-jekt“),

oder ein ganzes Wort (z. B. „Projektmanagement“).

Welche Aufteilung gewählt wird, hängt vom jeweiligen Tokenisierungsverfahren und ganz besonders vom Textkorpus, mit dem die Tokenisierung erfolgt, ab.

Warum ist das nötig? Sprachmodelle arbeiten sequenziell, sie erzeugen einen Antworttext, indem sie Schritt für Schritt eine Zeichenkette aufbauen. Aufgrund der Architektur der Modelle wird ein fester Zeichensatz benötigt, denn neuronale Netze, auf denen die Sprachmodelle basieren, haben eine Eingabe- und Ausgabeschicht, die jeweils eine bestimmte Anzahl an Neuronen enthalten. Jedem Neuron der Ausgabeschicht ist dabei ein Element aus dem Zeichensatz (einem Token) zugeordnet.

Das Ergebnis eines „Denkschritts“ des neuronalen Netzes ist eine Werteverteilung an der Ausgabeschicht. Das Zeichen, das zu dem Neuron mit dem höchsten Wert gehört, wird dann an die Zeichenkette angehängt. Der Prozess wird wiederholt, bis der Antworttext fertig ist.

Textgenerierung

1. Das Modell erzeugt aufgrund von Nutzereingabe und schon vorhandenen Antworttext eine Wahrscheinlichkeitsverteilung über alle Token.

2. Das Token mit dem höchsten Wert wird ausgewählt und an den Ausgabetext angehängt.

3. Schritt 1 und 2 werden wiederholt, bis die Antwort vollständig ist.

Warum ist Tokenisierung wichtig für NLP und KI-Modelle?

Die Tokenisierung ist mehr als ein technischer Vorbereitungsprozess. Sie bestimmt die Rahmenbedingungen der Arbeit mit Sprachmodellen.

Was ist NLP?

Natural Language Processing (NLP) ist ein Teilbereich der künstlichen Intelligenz (KI), der sich speziell mit der Verarbeitung und dem Verstehen menschlicher Sprache und geschriebener Texte befasst. Typische Anwendungen sind Chatbots, automatische Übersetzung, Sprachassistenten wie Alexa oder Siri, Textanalyse oder Sentiment-Analyse.

Die maximale gleichzeitig verarbeitbare Textgröße wird nach Token bemessen. Die Kosten berechnen sich nach der Anzahl der Token in Frage und Antwort.

Maximale Textlänge nach Token

Die Modelle arbeiten mit einem festen Zeichensatz. Die gleichzeitig verarbeitbare Textgröße wird nach Token bemessen, nicht nach Wörtern oder Zeichen.

Das sogenannte Kontextfenster legt fest, wie viele Token ein Modell auf einmal „sehen“ kann. GPT-4o beispielsweise kommt auf bis zu 128.000 Token – genug für ganze Bücher – GPT-5 sogar auf bis zu 400.000 Token. Doch jedes zusätzliche Token beansprucht Speicher und Rechenzeit.

Kosten nach Token

Auch die Kosten berechnen sich nach der Anzahl der verarbeiteten Token. Deshalb spielt es eine Rolle, wie effizient ein Text zerlegt wird. Ein Text, der auf Englisch nur 20 Token benötigt, kann auf Deutsch schnell eineinhalb mal so viele haben und damit teurer werden.

Sprachunterschiede

Englisch benötigt die wenigsten Token, die größeren europäischen Sprachen etwas mehr, einzelne seltene Sprachen benötigen mehr als das Zehnfache. Das bedeutet: Englisch ist günstiger, schneller und performanter – ein wichtiger Praxisfaktor, wie wir später noch zeigen. Konkret kann man für englische Texte ungefähr 10 % mehr Token als Wörter erwarten, bei deutschem Text sind es etwa 20-30 % mehr Token als Wörter. Mehrsprachige Tokenizer brauchen in der Regel mehr Token als einsprachige. (Quelle: https://jina.ai/de/news/a-deep-dive-into-tokenization/)

Wie funktioniert Tokenisierung in der Praxis?

Zeichen-Tokenisierung

Naheliegend wäre es, einzelne Buchstaben, Zahlen und Satzzeichen als Token zu nehmen. Dann käme das Modell mit viel weniger Token aus.

Beispiel:

„Projektmanagement“ → [„P“, „r“, „o“, „j“, „e“, „k“, „t“, „m“, …]

Das macht das Vokabular sehr klein. Aber: Ein einziges Wort wird in viele Token zerlegt. Das Modell müsste also über sehr lange Sequenzen hinweg Bedeutungen erkennen. Das wäre ineffizient und fehleranfällig.

Wort-Tokenisierung

Am anderen Ende steht die Zerlegung in ganze Wörter:

Beispiel:

„Projektmanagement ist komplex.“ → [„Projektmanagement“, „ist“, „komplex“, „.“]

Nur ganze Wörter als Token zu nehmen, scheidet aus, denn das Vokabular würde zu groß werden. Schon für Deutsch müssten Millionen Wörter berücksichtigt werden – inklusive Beugungen, Dialekte und Neologismen.

Subword-Tokenisierung – der Standardansatz

Die Lösung moderner Modelle ist ein hybrider Ansatz, die Subword-Tokenisierung: Zunächst werden alle einstelligen Zeichen als Token genommen, dann nach Häufigkeit Zeichenpaare, dann Dreiergruppen und längere Ketten, bis die durch das Modell mögliche Anzahl an Token erreicht ist. Alle Wörter, denen kein einzelnes Token entspricht, werden aus mehreren Token zusammengesetzt. Häufig vorkommende Wörter oder Wortteile erhalten eigene Token, seltenere Wörter werden in kleinere Token zerlegt.

Beispiel:

„Projektmanagement“ → [„Projekt“, „manage“, „ment“]

Byte-Pair-Encoding

Ein weit verbreitetes Verfahren zur Subword-Tokenisierung großer Textmengen ist das Byte-Pair-Encoding (BPE).

Vorgehen

- Wir beginnen mit allen Zeichen als eigenständigen Token.

- Nun suchen wir die am häufigsten vorkommenden Zeichenpaare.

- Wir fassen diese Paare zu neuen Token zusammen.

- Wir wiederholen den Vorgang, bis die gewünschte Vokabulargröße erreicht ist.

Beispiel (vereinfacht):

Satz: „Mit der Projektmanagement-Software Projektron BCS haben Sie Projekte und Geschäftsprozesse im Griff.“

- Start: ["M", "i", "t", " ", "d", "e", "r", " ", "P", "r", "o", "j", "e", "k", "t", ...]

- Erster Schritt, häuftigstes Paar finden „ro“ kommt am häufigsten vor (5 x) ersetzen: ro -> ↑

- „Mit der P↑jektmanagement-Software P↑jekt↑n BCS haben Sie P↑jekte und Geschäftsp↑zesse im Griff.“

- Danach kommt ↑j als häufigstes vor, ersetzen: ↑j wird zu ↔, außerdem kt -> ↗

- „Mit der P↔e↗management-Software P↔e↗↑n BCS haben Sie P↔e↗e und Geschäftsp↑zesse im Griff.“

- Jetzt haben wir drei neue Token, die ro, kt und roj bedeuten.

- “_P” (Leerzeichen und P) kommt drei mal vor, ersetzen durch ↘ “Mit der↘↔e↗management-Software↘↔e↗↑n BCS haben Sie↘↔e↗e und Geschäftsp↑zesse im Griff.”

- “↘↔”, die Bereits für "_Proj" stehen kann man zusammenfassen zu ⇔ und erhält “Mit der⇔e↗management-Software⇔e↗↑n BCS haben Sie⇔e↗e und Geschäftsp↑zesse im Griff.”

Ähnlich entstehen auch nützliche Einheiten wie:

- „manage“ (aus Management)

- „Software“

- „BCS“ (als eigenes Token, weil es öfter wiederholt wird)

- „Geschäftsprozesse“ könnte in Subwords wie „Geschäfts“, „prozesse“ zerlegt sein.

Ergebnis

Anstatt jedes Zeichen einzeln zu speichern, haben wir jetzt Subwords:

["Mit", "der", "Projekt", "manage", "ment", "-", "Software", "Projektron", "BCS", "haben", "Sie", "Projekte", "und", "Geschäfts", "prozesse", "im", "Griff"]

So entstehen Token, die für viele Texte nützlich sind. Das Verfahren erlaubt es, mit relativ wenigen Token sehr große Textmengen effizient darzustellen.

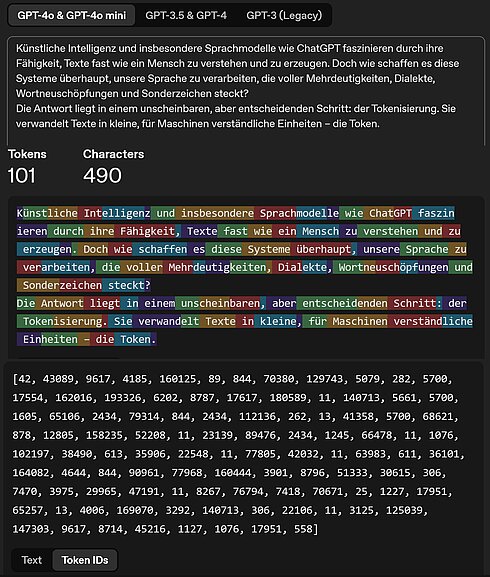

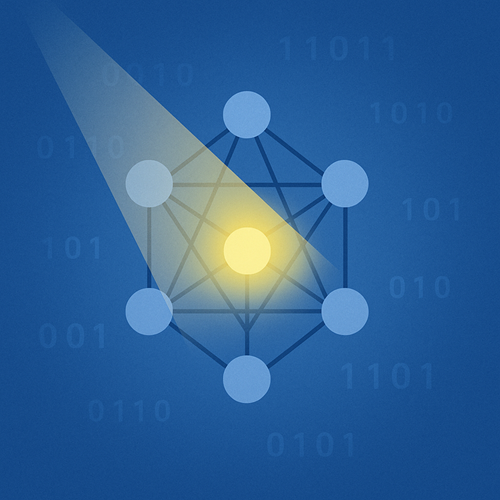

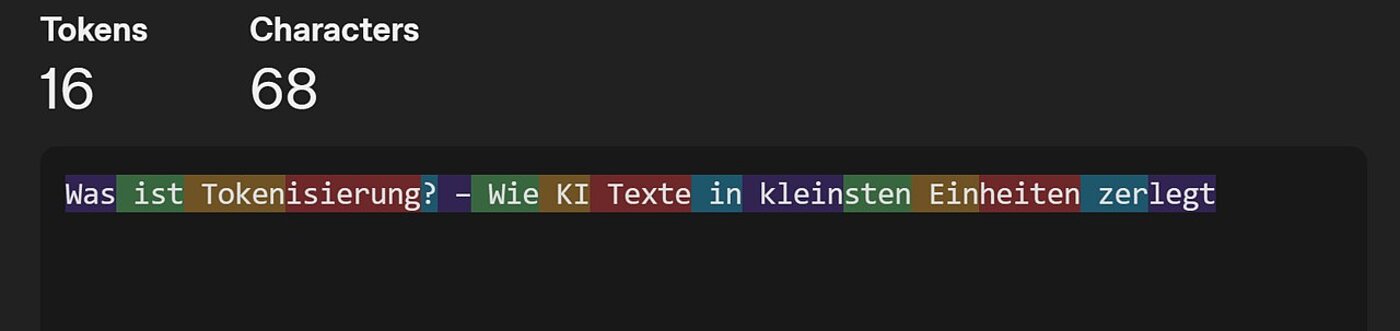

Beispiel der Tokenisierung mit deutschem Satz

Um einen Text testweise in Token umwandeln lassen, gibt es eine frei zugängliche Seite, den Tokenizer von OpenAI. Wer sich einmal den kompletten Tokensatz von OpenAIs GPT-4 ansehen möchte, kann das unter https://gist.github.com/s-macke/ae83f6afb89794350f8d9a1ad8a09193 tun.

Beispielhaft habe ich die Einleitung zu diesem Artikel einmal auf deutsch und einmal auf Englisch tokenisieren lassen und mir das Ergebnis jeweils einmal als Text und einmal als Token IDs anzeigen lassen

Wir sehen, die englische Variante hat nicht nur weniger Buchstaben, sondern wird in 14 Token weniger zerlegt als die deutsche Variante.

Welche Herausforderungen gibt es bei der Tokenisierung?

So ausgereift die Tokenisierung auch ist – in der Praxis stößt sie immer wieder auf Grenzen. Selbst wenn ein bestimmtes Modell keine optimale Tokenisierungsstrategie verwendet, kann es bei ausreichender Netzwerkgröße, genügend Daten und angemessenem Training lernen, das Richtige aus unvollkommenen Eingaben zu machen. Folglich wird weniger Aufwand in die Verbesserung der Tokenisierung gesteckt als in andere Bereiche. (Quelle: https://jina.ai/de/news/a-deep-dive-into-tokenization/). Der Fokus der Entwicklung liegt derzeit an anderer Stelle.

Die wichtigsten Herausforderungen sind:

1. Sprachspezifische Unterschiede

Sprachmodelle sind in erster Linie auf Englisch trainiert. Dort funktioniert die Tokenisierung besonders effizient: Texte benötigen vergleichsweise wenige Token. In anderen Sprachen – etwa im Deutschen mit seinen langen zusammengesetzten Wörtern – wächst die Tokenzahl deutlich an. Das macht Abfragen nicht nur teurer, sondern auch langsamer.

2. Sonderzeichen und Emojis

Auch Zeichen außerhalb des normalen Sprachgebrauchs können Probleme bereiten. Emojis, Symbole oder Mischungen aus Zeichenfolgen werden oft in viele einzelne Token zerlegt. Ein simples „✅⚡“ kann je nach Modell bis zu sechs Token beanspruchen.

3. Fachsprache und Abkürzungen

Besonders schwierig sind seltene Begriffe oder Abkürzungen, die im Trainingsmaterial kaum vorkommen. Ein Ausdruck wie „PMO-Board-Meeting“ wird häufig in mehrere Token zerlegt, was die Erkennung und Interpretation erschwert. Für Anwender bedeutet das, dass Modelle Fachsprache nicht immer zuverlässig verstehen.

4. Begrenztes Kontextfenster

Schließlich ist die Länge des Kontextfensters eine zentrale Einschränkung. Lange Texte müssen in Abschnitte aufgeteilt werden, sobald die Token-Grenze erreicht ist. Wie gut oder schlecht dieser Schnitt gelingt, hängt direkt von der Tokenisierung ab – und entscheidet, ob Sinnzusammenhänge erhalten bleiben oder verloren gehen.

Welche Erfahrung hat Projektron mit Tokenisierung?

Auf den ersten Blick klingt das Thema sehr technisch. Trotzdem hat es nach unseren Erfahrungen praktische Auswirkung auf die tägliche Arbeit. Es ist vorteilhaft, die System Prompts auf Englisch zu verfassen – sie werden besser verstanden, belasten das Kontextfenster weniger, sind performanter und günstiger.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

FAQ: Häufige Fragen zur Tokenisierung

Wie viel Text passt in ein KI-Modell?

Wie viel Text passt in ein KI-Modell?

Das hängt vom sogenannten Kontextfenster ab – also der maximalen Anzahl an Token, die das Modell gleichzeitig „im Blick“ haben kann. Bei GPT-4o sind das bis zu 128.000 Token, was in etwa 300 Buchseiten entspricht. Neuere Modelle wie GPT-5 gehen noch deutlich weiter und schaffen bereits 400.000 Token – genug für ganze Fachbücher oder umfangreiche Projektdokumentationen. Wichtig ist aber: Je näher man an diese Grenze stößt, desto höher sind die Rechenaufwände und damit auch die Kosten.

Wie viele Wörter entsprechen einem Token?

Wie viele Wörter entsprechen einem Token?

Eine direkte Umrechnung gibt es nicht, weil Token Wortteile, ganze Wörter oder auch nur Zeichen sein können. Im Durchschnitt hat sich aber gezeigt: In englischen Texten entspricht ein Token etwa 0,75 Wörtern, während es im Deutschen nur rund 0,5 Wörter sind. Das liegt an den längeren, zusammengesetzten Wörtern im Deutschen. So kann derselbe Satz je nach Sprache unterschiedlich viele Token beanspruchen – was wiederum Einfluss auf Kosten und Geschwindigkeit der Verarbeitung hat.

Kann ich die Token-Anzahl vorab berechnen?

Kann ich die Token-Anzahl vorab berechnen?

Ja, dafür gibt es praktische Hilfsmittel. Mit Online-Tools wie tiktokenizer.io oder direkt in der OpenAI-Plattform lässt sich die Tokenanzahl eines Textes zuverlässig bestimmen. Auch Bibliotheken wie tiktoken (Python) können lokal integriert werden. Für Unternehmen oder Entwickler ist es sinnvoll, Texte vor der Übergabe an ein Sprachmodell zu prüfen – so lassen sich Kosten kalkulieren und das Risiko vermeiden, dass der Text die Kontextgrenze sprengt.

Warum ist KI in Englisch günstiger?

Warum ist KI in Englisch günstiger?

Der Hauptgrund liegt in der Token-Effizienz. Da die meisten Modelle überwiegend auf englischen Trainingsdaten beruhen, sind englische Texte deutlich kompakter tokenisiert. Ein Satz benötigt im Englischen oft nur 80 Prozent der Token, die ein deutscher Satz benötigen würde. Das bedeutet: Abfragen auf Englisch verbrauchen weniger Platz im Kontextfenster, laufen schneller durch und kosten weniger Geld. Deshalb empfehlen viele Entwickler – und auch wir in Projektron – System-Prompts möglichst in Englisch zu verfassen, auch wenn die Ausgaben später wieder in Deutsch erfolgen können.

Fazit: Kleine Einheiten, große Wirkung

Die Tokenisierung ist ein unscheinbarer, aber zentraler Baustein in der Funktionsweise moderner Sprachmodelle. Sie entscheidet, wie effizient und präzise Texte verarbeitet werden und beeinflusst damit Kosten, Geschwindigkeit und Verständlichkeit von KI-Systemen.

Für Unternehmen, die KI gezielt einsetzen, ist es hilfreich, die Mechanismen dahinter zu kennen. Bei Projektron konnten wir durch ein besseres Verständnis der Tokenisierung unsere KI-Hilfe in BCS performanter, günstiger und anwenderfreundlicher gestalten.

Wie wir die Projektron-KI-Hilfe konkret entwickelt haben und welche Rolle die Tokenisierung dabei im Hintergrund spielt, erfahren Sie im Artikel „Projektron und KI: Erfahrungen bei Entwicklung und Optimierung der BCS-Hilfe“.

Über den Autor

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Hilfe in BCS

Die neue BCS KI-Hilfe bietet seit Version 25.3 präzise Antworten auf Fragen zur Projektron-Dokumentation. Der Artikel zeigt, wie iterative Optimierungen im Retrieval und Splitting die Antwortqualität deutlich verbessert haben.

Auswahl einer PM-Software

Steht in Ihrem KMU oder Ihrem Konzern die Auswahl einer Projektmanagement-Software an, wissen Sie vermutlich gar nicht, wo Sie mit der Suche nach dem für Sie passenden PM-Tool anfangen sollen. Dieser Guide bahnt Ihnen den Weg durch den PM-Software-Markt und führt Sie in 9 Schritten zur richtigen Entscheidung.