04.12.2025 - Fachartikel

Ein KI-Framework für BCS: Anforderungen und Architektur

In den vergangenen Monaten hat Projektron intensiv daran gearbeitet, ein leistungsfähiges und zukunftssicheres KI-Framework für BCS zu entwickeln. Nachdem wir in früheren Beiträgen erste Experimente mit Sprachmodellen, RAG-Konzepten und Prompt-Engineering vorgestellt haben, richtet sich der Fokus nun darauf, wie aus diesen Erkenntnissen eine robuste, produktiv nutzbare Systemarchitektur entsteht.

Ziel ist nicht die Entwicklung einzelner isolierter KI-Funktionen, sondern eines modularen Rahmens, in dem verschiedene Anwendungen betrieben, kombiniert und flexibel weiterentwickelt werden können. Dieser Beitrag beschreibt die zentralen Anforderungen, die Projektron an ein solches Framework stellt, die grundlegende Architektur dahinter und die technischen Entscheidungen, die zu seiner Umsetzung führen.

Allgemeine Anforderungen an unsere KI-Lösung

Wir wollten bei Projektron, insbesondere für unsere Software BCS, keine punktuellen Lösungen schaffen, sondern ein flexibles Framework entwickeln, das möglichst generisch funktioniert. Dieser KI-Assistent soll aus einzelnen Anwendungen aufgebaut sein, die festlegen, welche Aufgabe wie mit welchen Ressourcen gelöst werden soll. Die Anwendungen sollen verkettet werden können (KI-Workflows).

Als Ergebnis der im Sommer 2024 abgeschlossenen vorgelagerten Forschung und Tests werden wir uns bei den Techniken auf RAG und Prompt Engineering konzentrieren. Wir beschränken uns auf die Nutzung des Sprachverständnisses der Modelle, und vermeiden den Rückgriff auf Trainingswissen. Auf diese Weise sollen Halluzinationen verhindert werden.

Das Framework soll so aufgebaut sein, dass die einzelnen Komponenten wie Sprachmodell, Embedding-Modell oder Vektordatenbank leicht ausgetauscht werden können. Wir wollen wegen der schnellen und unabsehbaren Entwicklung unabhängig von bestimmten Produkten bleiben. Wichtig ist die Anforderung, dass das Framework komplett lokal betreibbar sein soll, um allen Anforderungen nach Datensicherheit und Datenschutz genügen zu können.

Entscheidend für den Erfolg ist aus unserer Sicht eine hohe Antwortqualität. Die Antworten sollen präzise und zutreffend sein. Wenn eine Frage aufgrund des Kontextmaterials nicht beantwortet werden kann, soll die KI das so rückmelden, und nicht versuchen, sich etwas zusammenzureimen (Halluzinationen). Die Nachverfolgbarkeit der Antworten ist ein wichtiges Qualitätskriterium. Die Quelle der Information soll, wo immer möglich, in der Antwort verlinkt werden, sodass sie mit einem Klick überprüft werden kann.

Da die Entwicklung von KI-Anwendungen versuchs- und testlastig ist, sind Erleichterungen bei den Lernschleifen wichtig. Ein Schwerpunkt liegt auf einem umfangreichen und gut lesbaren Logging der KI-Aktionen. Das ist essenziell, um unerwarteten Resultaten nachgehen zu können, und den Punkt zu finden, der verbessert werden muss. Ein Nutzer-Feedback wird mitgeschrieben und ausgewertet.

Ende 2026 soll das Framework als Teil von BCS an Kunden ausgeliefert werden. Die Kunden mit lokalen BCS-Installationen werden eine Anleitung bekommen, wie auch sie diesen Service nutzen können.

Geplant ist, dass Projektron im Laufe des Jahres 2026 einen Grundbestand an vorgefertigten Anwendungen liefert. In einem zweiten Schritt kann der Kunde zusätzlich eigene "Anwendungen" erstellen. Die Technik soll daher auch für heterogene Ausgangsdaten funktionieren.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

Architektur

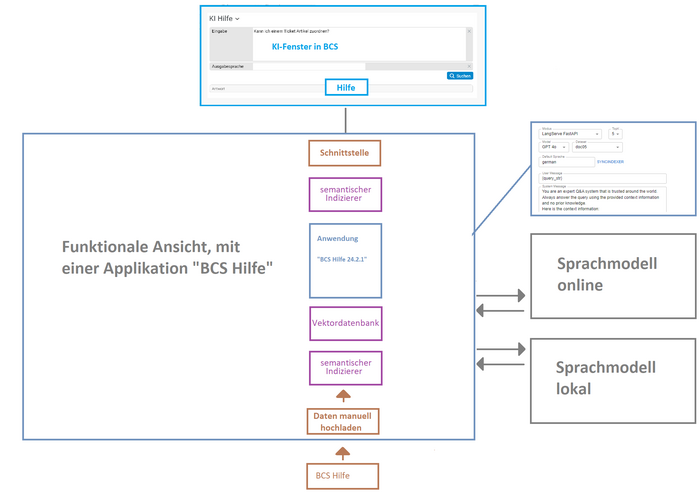

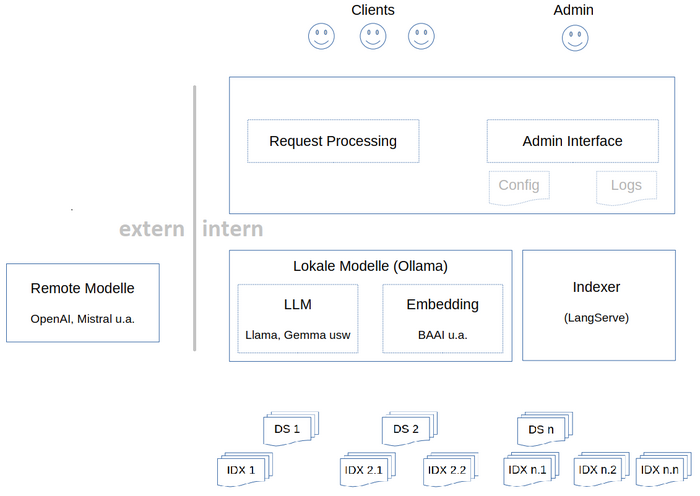

Die funktionale Sicht auf das Framework zeigt die folgende Grafik. Eingetragen ist als erste Anwendung die Softwarehilfe. Schnittstellen bestehen zu Datenquellen, zu Sprachmodellen, zur Ergebnisanzeige in BCS sowie über ein User Interface (UI) zum Administrator des Frameworks. Über das UI definiert der Administrator die Applikationen. Kern ist das System-Prompt, das festlegt, was die Anwendung leisten soll. Zusätzlich legt er das Sprachmodell (intern/extern) fest und kann Parameter eingeben. Wenn es sich, wie bei der Hilfe, um einen RAG-Applikation handelt, lässt sich steuern, wie aus dem Datensatz der Vektorindex erzeugt wird, beispielweise die Art und Größe der Textsplitts, oder wie viele Treffer zurückgegeben werden, und wie hoch diese mindestens bewertet sein müssen.

Von BCS aus wird das Framework über eine Schnittstelle angesprochen. Wenn ein Nutzer eine Frage in das KI-Hilfe-Fenster eingibt, wird eine Anfrage an das Framework gestellt, in der die betreffende Applikation als Parameter enthalten ist. Je nachdem, welche Aufgabe erledigt werden soll (Hilfe, Ticket zusammenfassen) können über die Schnittstelle verschiedene Applikationen angefragt werden.

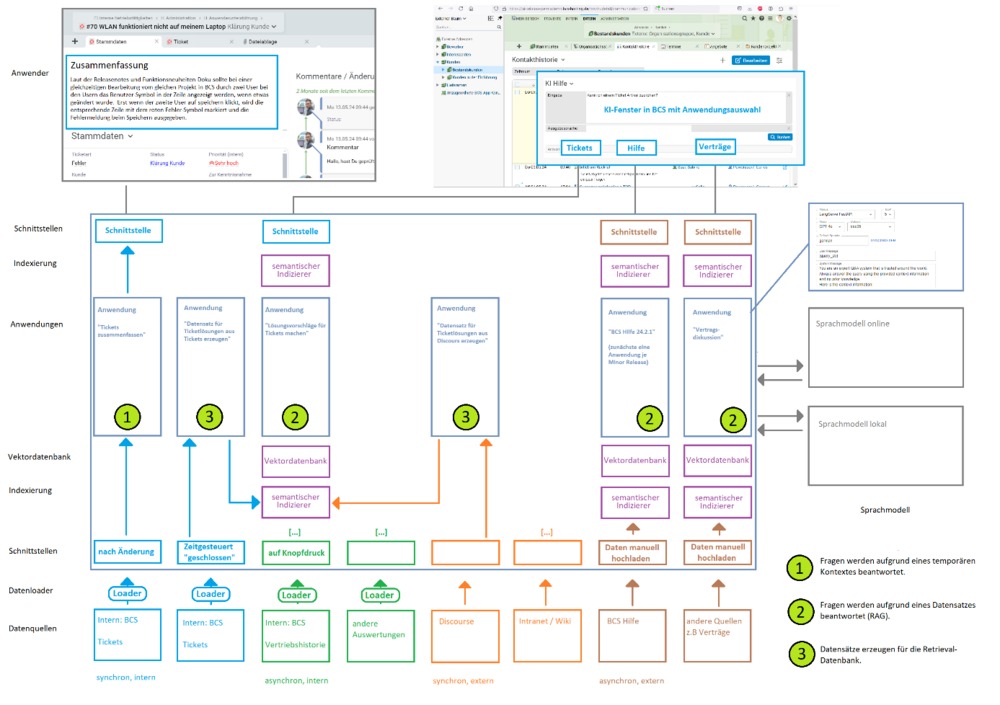

Das Framework kann eine größere Zahl Applikationen enthalten, wie die folgende Grafik zeigt. Applikationen können verkettet werden. So kann beispielsweise aus den geschlossenen Tickets mit einem lokalen Modell ein Datensatz erzeugt werden, der aus anonymisierten Zusammenfassungen besteht. Dieser Datensatz steht dann zur Beantwortung von neu hereinkommenden Tickets zur Verfügung.

In einer späteren Version kann der Kunde eigene individuelle Applikationen definieren, die nichts mit BCS zu tun haben müssen. Im Bild ist das beispielhaft ganz rechts dargestellt, „Verträge“. Diese stellt eine Unterstützung für Mitarbeiter dar, die häufig Verträgen verhandeln oder erklären müssen, wie es in einer Softwarefirma der Fall ist, wo mit jedem neuen Kunden ein Lizenzvertrag abgeschlossen wird. Die meisten dieser Fragen wurden bereits früher einmal beantwortet. Auf diese Erfahrungen kann mit einer KI-Applikation zurückgegriffen werden, um die Bearbeitung neuer Fälle zu beschleunigen. Der Datensatz besteht aus Dokumenten, die jeweils einen Vertragsparagrafen enthalten, die früher gestellte Kundenfrage dazu, und die getroffene Entscheidung. Das kann einfach über eine Sammlung von .txt-Dateien geschehen. Diese werden wie die Hilfedokumente verarbeitet, es wird ein Vektorindex erzeugt, der dann befragt werden kann.

Auf die gleiche Weise kann ein Kunde firmenindividuelle Prozessanweisungen, Sicherheitsrichtlinien und ähnliche Datensammlungen durch KI befragbar machen.

Die technischen Komponenten zeigt die folgende Grafik. Grundsätzlich sind diese alle austauschbar, um auf die schwer vorhersehbaren, raschen Entwicklungen auf dem Feld reagieren zu können. Die serverartigen Komponenten wie Ollama und LangServe sind tiefer verankert, sie haben einen standard-nahen Status und werden auch weithin in der Industrie verwendet (Stand Dezember 2024). Komponenten wie das Text-Embedding haben wir durch Test ausgewählt, dazu später mehr. Die Sprachmodelle lassen durch einen einfachen Konfigurationseintrag auswechseln.

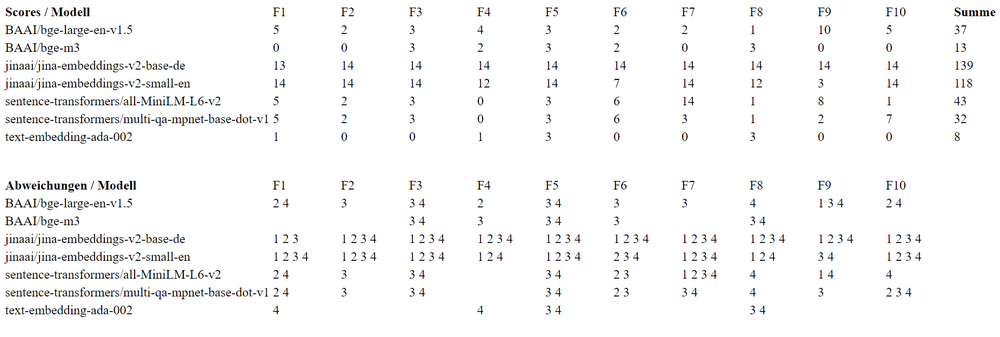

Um ein lokales Embedding-Modell auszuwählen, haben wir einen Vergleichstest mit verschiedenen Produkten gemacht. Als Benchmark haben wir OpenAIs text-embedding-ada verwendet, das aber nicht lokal betrieben werden kann. Basis des Tests war ein Datensatz von ca. 100 Texten und 10 Fragen, die jeweils spezifisch zu einem Text gestellt wurden, sodass klar war, welcher Text der Top-Treffer zur Frage sein sollte. Die Texte wurden in die RAG-Lösung von OpenAI eingespielt, die Fragen gestellt, und die jeweils 4 Treffer (also TopK=4) mitgeschrieben. OpenAI konnte die Fragen gut beantworten, die erwarteten Dokumente kamen an erster Stelle. Verglichen haben wir mit 6 lokalen Embedding-Modellen sowie dem auch einzeln, aber nur online verfügbaren text-embedding-ada-002. Die 10 Fragen wurden gestellt, und die jeweils 4 Treffer mit dem Benchmark verglichen. Für eine Abweichung an Pos 1 gab es 7 Punkte, dann 4, 2 und 1 Punkt. Das lokale Modell mit der geringsten Punktzahl haben wir ausgewählt. Das war BAAI/bge-m3 von der Beijing Academy of Artificial Intelligence.

Die Ergebnisse im Einzelnen zeigt die folgende Tabelle: oberer Teil die Punkte zu jeder Frage, unterer Teil, welche Texte jeweils abweichend herausgesucht wurden. Wir planen, den Test in Abständen zu wiederholen; bei wesentlichen Verbesserungen könnten wir das Embedding-Modell wechseln. Allerdings müssten man dann den gesamten Dokumentenbestand neu indizieren, was einen gewissen Aufwand bedeutet.

Damit sind die technischen Überlegungen und Aspekte des Frameworks beschrieben. Durch viele kleine Tests und Feedbackschleifen haben wir sichergestellt, dass das grundsätzliche Setup nach unseren Vorstellungen funktioniert.

Ausblick

RAG und Chat

Durch ChatGPT sind viele Nutzer eine Chatfunktion gewöhnt. Wenn die Antwort nicht klar oder gut ist, fragt man eben noch mal nach. Wahrscheinlich ist das der erfolgversprechendste Weg zu weiter verbesserten Ergebnissen, auch bei der Hilfe. Das Problem im Zusammenhang mit RAG ist eine Fallunterscheidung: wenn der Nutzer die zweite Frage stellt, muss die KI beurteilen, ob sie zum alten Thema gehört, und wenn ja, ob die herausgesuchten Informationen ausreichen, oder noch einmal gesucht werden muss. Wenn es ein neues Thema ist, muss der bisherige Kontext ignoriert werden, damit er nicht in die Irre führt. Wir arbeiten also daran, die Fallunterscheidung und den Folgeprozess sauber hinzubekommen.

Feedback

Bereits jetzt kann der Nutzer im Hilfefenster rückmelden, ob er die Antwort hilfreich fand oder nicht. Hier sehen wir Potenzial für weitere Prozesse, zum Beispiel bei negativem Feedback die FAQ um eine Information zu erweitern, die die gesuchte Information bereitstellt.

Über die Autoren

Maik Dorl ist einer der drei Gründer und bis heute einer der Geschäftsführer der Projektron GmbH. Seit der Gründung im Jahr 2001 prägt er die strategische Ausrichtung des Unternehmens und zeichnet sich heute verantwortlich für die Bereiche Vertrieb, Kundenbetreuung und Produktmanagement. Als Produktmanager ist er die treibende Kraft hinter der Integration innovativer KI-Anwendungen in die ERP- und Projektmanagementsoftware BCS.

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Hilfe in BCS

Die neue BCS KI-Hilfe bietet seit Version 25.3 präzise Antworten auf Fragen zur Projektron-Dokumentation. Der Artikel zeigt, wie iterative Optimierungen im Retrieval und Splitting die Antwortqualität deutlich verbessert haben.

Vergleich: ERP für Dienstleister

Für Dienstleister entscheidet die Wahl der ERP-Lösung über Effizienz, Transparenz und Umsatz. Unser Vergleich zeigt die besten Systeme, erklärt, welche Funktionen wirklich wichtig sind, und gibt wertvolle Tipps für die Auswahl. Finden Sie jetzt das ERP, das Ihr Unternehmen wirklich voranbringt!