06.11.2025 - Fachartikel

Vektorisierung in der KI — Wie Wörter zu Zahlen werden

Was passiert, wenn künstliche Intelligenz Wörter in Zahlen verwandelt? Hinter modernen Sprachmodellen steckt ein unscheinbares, aber zentrales Prinzip: Vektorisierung. Sie übersetzt Sprache, Bilder und Töne in mathematische Strukturen und macht damit Verständnis, Suche und Generierung überhaupt erst möglich. In diesem Artikel erfahren Sie was unter Vektorisierung in der KI genau zu verstehen ist, wie Embeddings entstehen, warum KI-Systeme numerische Repräsentationen statt Wörter benötigen und wie diese Vektoren heute in Suchmaschinen, RAG-Systemen und Empfehlungssystemen eingesetzt werden. Mit einem anschaulichen Beispiel aus dem Mittelalter zeige ich Schritt für Schritt, wie semantische Beziehungen in mathematische Objekte überführt werden, von der One-Hot-Kodierung über Word2Vec bis hin zu kontextuellen Embeddings in modernen Transformer-Modellen.

Inhalt

Vektorisierung in der KI: So werden Wörter zu Zahlen

Wie schafft es Künstliche Intelligenz, Sprache zu „verstehen“? Die Antwort liegt in einem mathematischen Trick: Vektorisierung. Statt Wörter als Symbole zu behandeln, verwandelt die KI sie in Punkte in einem Raum – und erkennt darin Bedeutungsähnlichkeiten, Analogie-Beziehungen und Kontexte. Diese Punkte – also die numerischen Darstellungen der Wörter – nennt man Embeddings. Jedes Embedding ist ein Vektor, der die Bedeutung eines Wortes, Satzes oder Dokuments in Zahlen fasst. So entsteht ein „semantischer Raum“, in dem Nähe inhaltliche Ähnlichkeit ausdrückt.

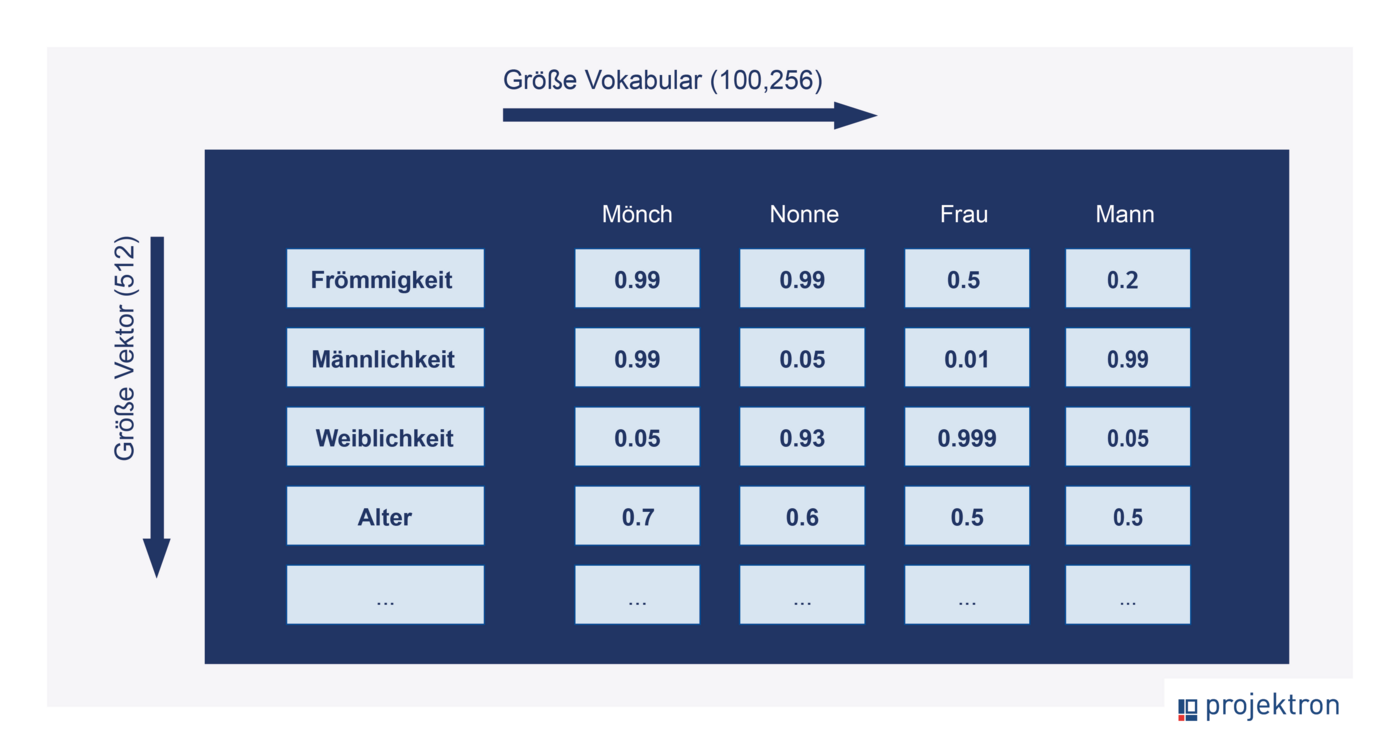

Um eine erste Idee zu bekommen, wie man sich ein solches „Embedding“ anschaulich vorstellen kann, reisen wir in Gedanken zurück ins Mittelalter. Die Klosterbibliothek soll vektorisiert werden. Die Mönche haben sich überlegt, die Bedeutung jedes Wortes ihres Vokabulars (sie kennen etwas mehr als 100.000 Wörter) durch eine gewichtete Zuordnung von 512 geschickt gewählten Adjektiven zu erfassen.

Für jedes Wort vergeben sie Werte (Gewichte) zwischen 0 und 1, die ausdrücken, wie stark das Wort auf dieser Achse ausgeprägt ist.

Beispiel

Katze → 0.9 „tierisch“, 0.8 „freundlich“, 0.2 „heilig“

Mönch → 0.1 „tierisch“, 0.2 „freundlich“, 0.9 „heilig“

→ Das ergibt für jedes Wort eine Zahlenreihe (Vektor) mit 512 Werten.

Diese Werte werden jeweils durch Umfrage unter den Mönchen bestimmt.

Wenn das gelingt, würde man Folgendes erwarten:

Ähnliche Wörter (Katze, Stubentiger) sollten ähnliche Vektoren ergeben. (oder, auf „Mathematisch“: Das Produkt zweier ähnlicher Vektoren sollte groß sein, zweier unähnlicher Vektoren klein.)

Mit den Vektoren sollte man „semantisch rechnen“ können. Wenn man den Begriffen Mann, Frau, Nonne, Mönch einen Vektor zuordnet, sollte das Ergebnis der Vektorrechnung Mönch − Mann + Frau den Vektor für Nonne ergeben.

So funktioniert „semantisches Rechnen“ mit Vektoren

Im Folgenden zeigt ein kleines Zahlenbeispiel, wie sich solche semantischen Analogien rechnerisch abbilden lassen: vier Begriffe werden auf vier Bedeutungsachsen als Vektoren dargestellt, und die Rechnung Mönch − Mann + Frau wird gegenübergestellt. Um die semantische Nähe messbar zu machen, werden die Vektoren zusätzlich normiert und durch Skalarprodukte verglichen – diese Werte zeigen, wie eng der berechnete Vektor der ‚Nonne‘ dem Originalvektor entspricht:

| Merkmal | Vektorwerte | Skalarprodukte | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| Mönch | Nonne | Frau | Mann | Berechnete Nonne: Mönch − Mann + Frau | Mönch × Mönch | Mönch × Nonne | Mönch × Frau | Mönch × Mann | Berechnete Nonne × Nonne | |

| Frömmigkeit | 0,99 | 0,99 | 0,5 | 0,2 | 1,29 | 0,498 | 0,514 | 0,316 | 0,140 | 0,565 |

| Männlichkeit | 0,99 | 0,05 | 0,01 | 0,99 | 0,01 | 0,498 | 0,026 | 0,006 | 0,691 | 0,000 |

| Weiblichkeit | 0,05 | 0,93 | 0,999 | 0,005 | 1,044 | 0,001 | 0,024 | 0,032 | 0,000 | 0,430 |

| Alter | 0,07 | 0,06 | 0,05 | 0,05 | 0,07 | 0,002 | 0,002 | 0,002 | 0,002 | 0,002 |

| Normierung (= Vektorlänge) | 1,403 | 1,361 | 1,118 | 1,011 | 1,661 | 1,00 | 0,57 | 0,36 | 0,83 | 0,997 |

| Ähnlichkeit, wobei 1 = identisch | ||||||||||

Dieses Gedankenexperiment zeigt: Vektorisierung übersetzt Sprache in eine Form, die semantische Nähe messbar macht. Das ist genau die Idee hinter modernen Embeddings. Moderne KI-Modelle erzeugen solche Embeddings, indem sie aus riesigen Textmengen lernen, statt, wie unsere Mönche, jede Dimension mühsam von Hand zu bestimmen. So entsteht die Grundlage, auf der Transformer-Modelle, Suchmaschinen, Empfehlungssysteme und RAG-Workflows Bedeutungen verstehen, vergleichen und kombinieren können.

Warum ist das so mächtig? Weil Vektoren rechnerisch vergleichbar sind. Ihre Ähnlichkeit lässt sich zum Beispiel mit dem Skalarprodukt (Dot-Product) messen – genau jene Operationen, die im Transformer-Mechanismus (Attention) eingesetzt werden. So kann die KI Beziehungen zwischen Wörtern (Token-Vektoren) erkennen, gewichten und kombinieren – alles auf Basis linearer Algebra.

Was versteht man unter Vektorisierung in der KI?

Vektorisierung in der KI bezeichnet den Prozess, bei dem Symbole – etwa Wörter, Token, Bildausschnitte oder Audioschnipsel – in numerische Vektoren übersetzt werden. Diese Vektoren, auch Embeddings genannt, sind die mathematische Repräsentation von Bedeutung. Sie bilden die Grundlage dafür, dass neuronale Netze Sprache, Bilder oder Töne überhaupt verarbeiten und „verstehen“ können. Vereinfacht gesagt: Ein KI-Modell weist jedem Wort einen Punkt in einem mehrdimensionalen Raum zu. Wörter, die in ähnlichen Kontexten vorkommen – etwa Katze und Stubentiger – liegen in diesem Raum nahe beieinander. So entsteht ein semantischer Vektorraum, in dem geometrische Nähe inhaltliche Ähnlichkeit widerspiegelt.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

Ein kleines praktisches Beispiel: One-Hot, Netzwerk, Embeddings

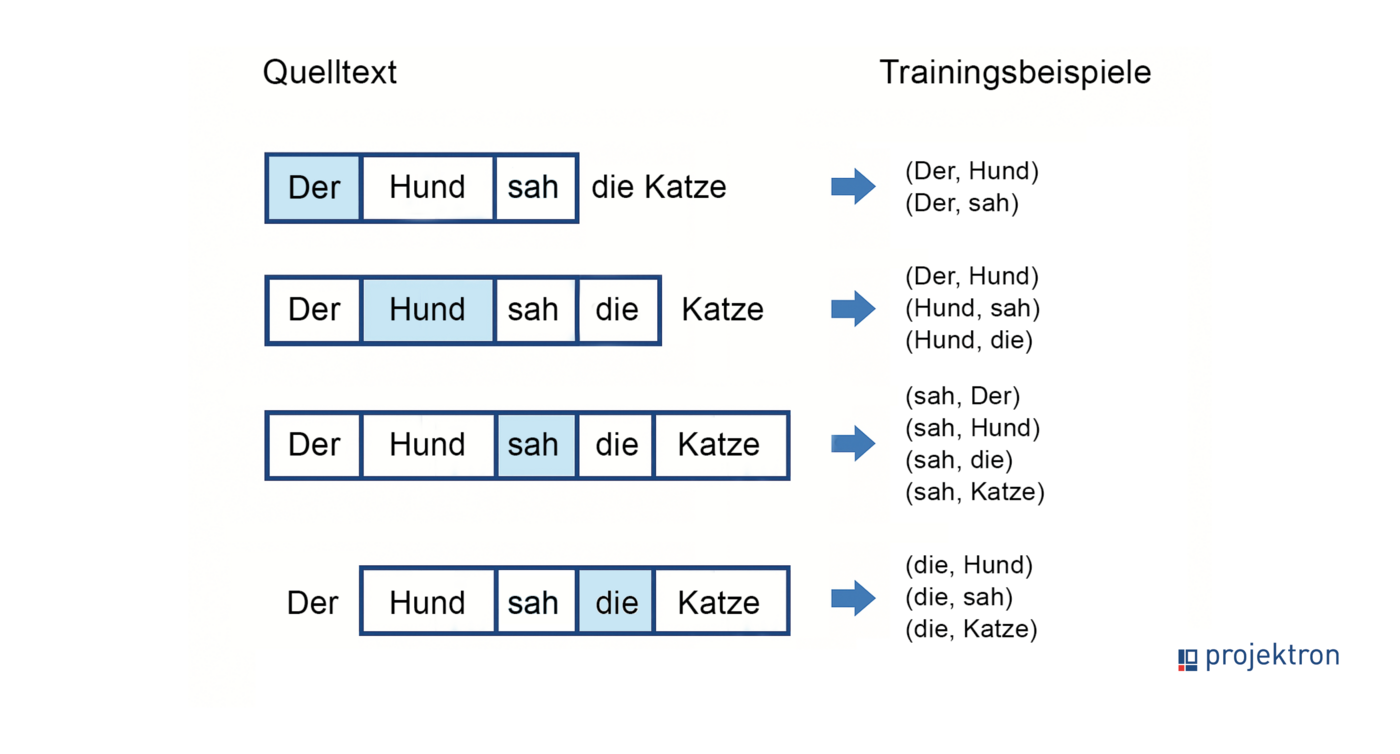

Jetzt wollen wir den Prozess automatisieren. Die grundsätzliche Idee ist es, die Vektoren durch die Analyse von Nachbarwörtern zu ermitteln. Um zu verstehen, wie ein Embedding auf diese Weise entsteht, betrachten wir ein stark vereinfachtes Beispiel.

1. Textkorpus und Vokabular

Zuerst brauchen wir einen möglichst großen Textkorpus, den wir auf Nachbarwörter analysieren können. Im nächsten Schritt erstellen wir daraus ein Vokabular. Mit dem Vokabular wollen wir später ein neuronales Netz trainieren. Hier ein vereinfachtes Beispiel mit einem Textkorpus, der nur aus drei Sätzen besteht:

Der Hund sah die Katze. Der Hund jagte die Katze. Die Katze rettete sich. |

|---|

Im nächsten Schritt erstellen wir daraus ein Vokabular. Das sieht in unserem Beispiel (alphabetisch geordnet) so aus:

|

|---|

2. One-Hot-Kodierung

Jedes Wort wird durch einen sogenannten One-Hot-Vektor dargestellt. Dieser Vektor ist so lang wie das Vokabular selbst und enthält an der Position des Wortes eine „1“, sonst nur Nullen. Beispiel:

Katze (0,0,0,0,1,0,0,0) rettete (0,0,0,0,0,1,0,0) |

|---|

Jetzt brauchen wir noch eine Sammlung von benachbarten Wörtern als Trainingsdaten. Das war ja die Idee, die Vektoren durch die Analyse von Nachbarwörtern zu ermitteln. Hier ist der Anfang einer Sammlung auf Basis unseres Textkorpus:

3. Training eines neuronalen Netzes

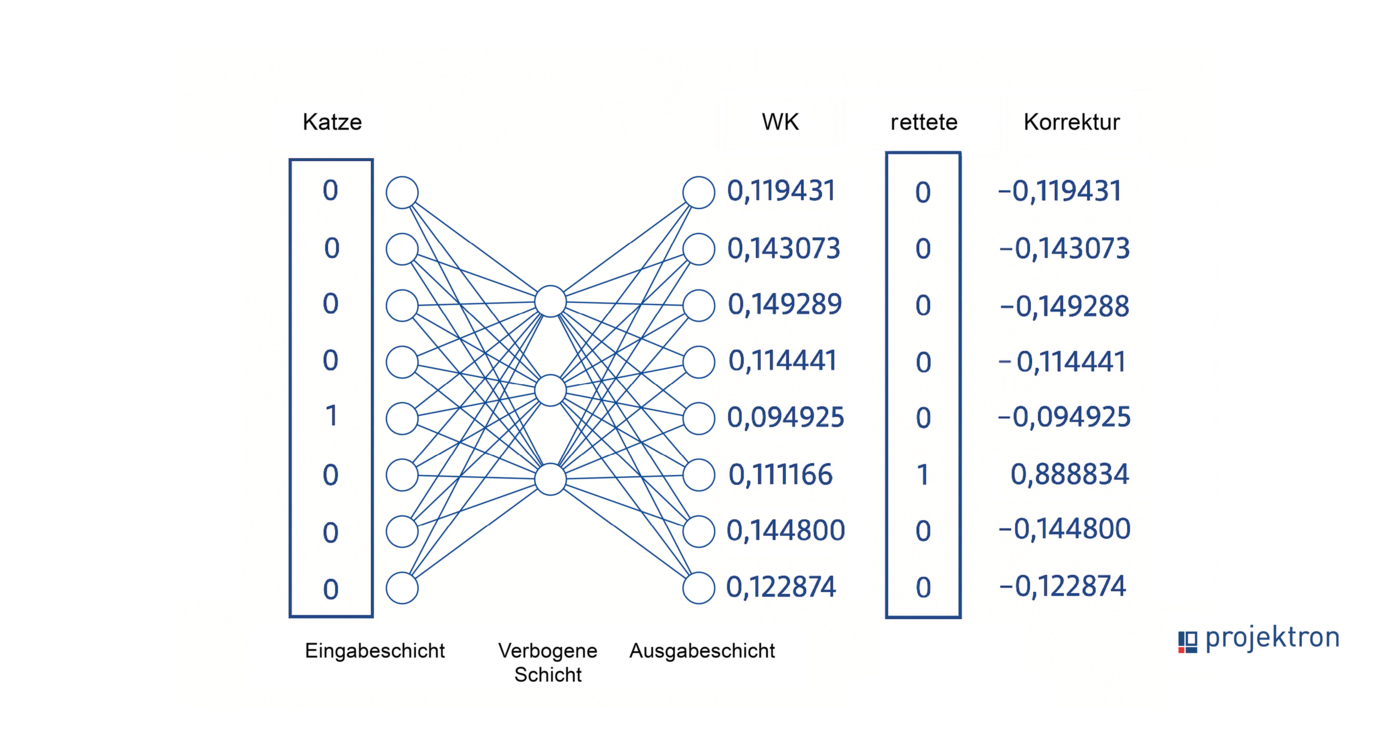

Jetzt kommt das Training. Dazu bauen wir uns ein neuronales Netz. Es besteht aus drei Schichten: Der Eingabeschicht, der mittleren (verborgenen) Schicht, und der Ausgabeschicht. Die Anzahl der Neuronen in den äußeren beiden Schichten liegt fest: sie entspricht der Größe unseres Vokabulars, also 8. Die Anzahl der Neuronen in der verborgenen Schicht können wir festlegen. Sie entspricht der Größe des Vektors, mit dem wir unser Vokabular semantisch beschreiben wollen. Hier haben wir 3 gewählt.

Die Neuronen aufeinanderfolgender Schichten sind jeweils vollständig verknüpft. Die Stärke der Verknüpfungen (Gewichte, Weights) gibt an, mit welchem Faktor der Wert eines Neurons an ein Neuron der folgenden Schicht weitergegeben wird. Am Anfang werden die Gewichte mit zufälligen Werten initialisiert. Das Netz wird dann darauf trainiert (d.h. die Gewichte werden angepasst), zu dem ersten Wort eines Nachbarpaars das zweite Wort vorherzusagen. Im folgenden Bild soll zu „Katze“ das Wort „rettete“ vorhergesagt werden.

Erklärung

Der Gewichtungskoeffizient (WK) ist der numerische Wert, den ein neuronales Netz einer bestimmten Eingabe zuordnet.

Er spiegelt wider, wie stark oder wahrscheinlich das Modell den jeweiligen Begriff als Wortpartner für das gegebene Eingabesignal hält.

Nach diesem WK kann ein Korrekturwert folgen – etwa ein Fehlermaß, Gradient, Loss-Wert oder eine Anpassung im Backpropagation-Schritt.

Am Anfang des Trainings berechnet unser Modell zu "Katze" einen Vektor, der mit dem gewünschten Vektor für "rettete" wenig übereinstimmt. Die Differenz zwischen Vorhersage und Erwartung fließt in eine Fehlerfunktion. Über viele Trainingsschritte (Backpropagation) mit allen Wortpaaren lernt das Netz, welche Wortkombinationen häufig zusammen auftreten und diese besser vorherzusagen. Da verschiedene Wörter Nachbarn des Wortes Katze sein können, wird die Vorhersage kein One-Hot Vektor sein, sondern an allen 8 Positionen Werte haben.

In unserem Textkorpus kommt die Kombination aus "Katze" und "die" häufig vor - also sollte bei Eingabe von "Katze" der zweite Eintrag im Ausgabe-Vektor nach dem Training recht hoch sein. Bei Eingabe von "Hund" sollte der achte Eintrag im Ausgabe-Vektor null sein, da die Kombination "Hund" und "sich" im Textkorpus nicht vorkommt und also auch nicht vorhergesagt werden darf.

4. Extraktion der Embeddings

Nach dem Training kann man für jedes Wort den Vektor aus der mittleren Schicht auslesen – das ist das Embedding. Diese Werte bilden die Position des Wortes im semantischen Raum, z. B.:

Katze → (0.519, 0.434, 0.047)

Dieses einfache Modell entspricht den frühen Word2Vec-Ansätzen (CBOW, Skip-Gram). Moderne Systeme – etwa BERT oder Transformer-Modelle – erweitern das Prinzip um Kontextabhängigkeit (Ein Wort (oder Token) wird nicht isoliert, sondern in seinem sprachlichen Umfeld interpretiert. Die Einbettung (Embedding) hängt vom Satz, Nachbarwörtern und syntaktischen Beziehungen ab), aber die Idee bleibt gleich:

Aus Sprache entstehen Vektoren, Vektoren beschreiben Bedeutung. |

|---|

Ohne Vektorisierung könnte keine KI semantische Beziehungen verstehen, kontextabhängig antworten oder Informationen im Vektorraum vergleichen.

Warum brauchen KI-Modelle Zahlen statt Wörter?

Kurz gesagt: Weil Künstliche Intelligenz mit Zahlen rechnet – nicht mit Symbolen.

Neuronale Netze führen Operationen der linearen Algebra aus. Wörter als Text sind dafür ungeeignet. Sie müssen zunächst in eine numerische Form gebracht werden.

Genau das leistet die Vektorisierung in der KI.

Ohne Vektorisierung gäbe es keine Transformer-Modelle, keine Attention-Mechanismen und keine semantische Suche. Die Umwandlung von Symbolen in Vektoren ist die Brücke zwischen Sprache und Mathematik, zwischen Bedeutung und Berechnung.

Wo wird Vektorisierung in KI praktisch eingesetzt?

Vektoren sind ein universelles Werkzeug und tauchen in vielen Bereichen der KI auf:

Suchmaschinen & semantische Suche: Dokumente und Suchanfragen werden gebündelt in Vektoren abgelegt; statt reiner Schlüsselwortsuche verwendet man Ähnlichkeitssuche in Vektorraum-Indizes (z. B. ANN-Index).

RAG (Retrieval-Augmented Generation): Bei Retrieval-basierter Textgenerierung sucht ein Vektorindex passende Knowledge-Chunks, die dann als Kontext an ein Sprachmodell gegeben werden.

Textklassifikation & Clustering: Embeddings erleichtern das Training von Klassifikatoren und das Erkennen natürlicher Gruppierungen.

Empfehlungssysteme: Item- und User-Embeddings ermöglichen Berechnungen wie „Nutzer X mag Objekte, die nahe an Y liegen“.

Positionsvektoren in Transformer-Architekturen: Token-Vektoren tragen zusätzlich Positionskodierungen — entweder sinusförmig oder als gelernte Vektoren — damit die Reihenfolge in Sequenzen erkennbar bleibt.

Multimodale Systeme: Bilder und Audio werden ebenfalls in Vektorräume eingebettet (Patch-Embeddings, Audio-Frames), was Cross-Modal-Retrieval und Multimodale Modelle ermöglicht.

Vektor-Datenbanken / ANN-Indizes: Technologien wie FAISS, Annoy oder HNSW sind auf effiziente Nachbarschaftssuche großer Embedding-Sammlungen spezialisiert.

Projektron-Erfahrungen mit Vektorisierung in der KI

Bei Projektron setzen wir Vektorisierung ein, um KI-Funktionen in BCS zu unterstützen – beispielsweise bei der Softwarehilfe. Dafür nutzen wir bewährte Bibliotheken, die Texte aus der Online-Hilfe und anderen Quellen in sogenannte Embeddings (numerische Vektoren) umwandeln. Diese Embeddings bilden die Grundlage für semantische Suchfunktionen und den Einsatz von Retrieval-Augmented Generation (RAG). So kann die KI auf vorhandenes Wissen zugreifen und gezieltere, inhaltlich passende Antworten liefern.

Ein erstes praktisches Anwendungsfeld ist der KI-gestützte Hilfe-Assistent in BCS. Dabei werden Hilfedokumente in Abschnitte („Textsplits“) zerlegt, vektorisiert und in einer Vektordatenbank gespeichert. Wenn eine Nutzerfrage eingeht, wird auch diese in einen Vektor übersetzt und mit den gespeicherten Textvektoren verglichen. Die inhaltlich ähnlichsten Treffer werden anschließend als Kontext an das Sprachmodell übergeben. So kombiniert das System semantische Suche mit generativer KI und liefert Nutzern präzise, erklärende Antworten.

Zur Auswahl eines geeigneten Embedding-Modells haben wir mehrere Varianten getestet. Als Benchmark diente das OpenAI-Modell text-embedding-ada, das allerdings nur cloudbasiert verfügbar ist. Getestet wurden daneben verschiedene lokal betreibbare Modelle, aus denen das Modell BAAI/bge-m3 der Beijing Academy of Artificial Intelligence als für uns beste lokale Lösung hervorging. Während Cloud-Modelle tendenziell eine höhere Genauigkeit erreichen, bieten lokale Modelle Vorteile beim Datenschutz und in der Integration in bestehende Systeme.

Ein wichtiges Ergebnis aus den Test- und Verbesserungszyklen war die Bedeutung der richtigen Textaufbereitung: Die Größe der Textabschnitte beeinflusst die Ergebnisqualität erheblich. Um kontextfreie Fragen besser beantworten zu können, wurde deshalb eine Erweiterung („Parent Document Retrieval“) implementiert, die bei Bedarf ganze Dokumente als Kontext heranzieht.

Die Vektorisierung und semantische Suche bilden heute die technische Basis unseres KI-Frameworks und damit auch die Grundlage für zukünftige Anwendungen in BCS, etwa zur Unterstützung bei Verträgen, Prozessanweisungen oder anderen Wissensquellen.

Fazit: Vektorisierung – das Fundament unserer KI-Ansätze

Vektorisierung ist die zentrale Technik, die Sprache, Bilder oder andere komplexe Inhalte in eine numerische Form bringt, die neuronale Netze verstehen können. Sie übersetzt Bedeutung in eine mathematisch verarbeitbare Form. Wörter, Sätze oder ganze Dokumente werden zu Punkten in einem mehrdimensionalen Raum, deren Abstände semantische Nähe ausdrücken.

Von frühen Verfahren wie Bag-of-Words oder Word2Vec, bei denen feste Wortvektoren trainiert werden, bis hin zu modernen kontextabhängigen Embeddings aus Transformer-Modellen bleibt der Grundgedanke gleich: Bedeutung entsteht durch Muster in Zahlenräumen.

Das Beispiel des „mittelalterlichen Klosters“ verdeutlicht dieses Prinzip anschaulich: Wenn man Begriffe durch gewichtete Eigenschaften beschreibt (z. B. Lage, Größe, Zweck, Alter), entsteht eine numerische Signatur, anhand derer sich Ähnlichkeiten messen und kombinieren lassen. Moderne KI-Methoden führen genau diese Idee fort, nur automatisiert, skaliert und mathematisch optimiert.

So bildet Vektorisierung heute die Basis vieler KI-Anwendungen: von semantischer Suche und Textklassifikation über Empfehlungssysteme bis hin zu generativen Assistenten wie RAG. Sie macht Wissen maschinenlesbar und schafft damit die Grundlage, auf der KI sinnvoll mit menschlicher Sprache interagieren kann.

Über den Autor

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Hilfe in BCS

Die neue BCS KI-Hilfe bietet seit Version 25.3 präzise Antworten auf Fragen zur Projektron-Dokumentation. Der Artikel zeigt, wie iterative Optimierungen im Retrieval und Splitting die Antwortqualität deutlich verbessert haben.

Auswahl einer PM-Software

Steht in Ihrem KMU oder Ihrem Konzern die Auswahl einer Projektmanagement-Software an, wissen Sie vermutlich gar nicht, wo Sie mit der Suche nach dem für Sie passenden PM-Tool anfangen sollen. Dieser Guide bahnt Ihnen den Weg durch den PM-Software-Markt und führt Sie in 9 Schritten zur richtigen Entscheidung.