19.11.2025 - Fachartikel

RAG (Retrieval-Augmented Generation): So profitieren KI-Anwendungen davon

Sprachmodelle wie GPT, BERT oder LLaMA haben ein beeindruckendes Sprachverständnis. Sie können Texte zusammenfassen, formulieren oder übersetzen – und dabei sogar einen Hauch von Stilbewusstsein zeigen. Doch ein entscheidender Nachteil bleibt: Das Wissen dieser Modelle endet zum Zeitpunkt des Trainings. So wissen sie noch, wer Amerika entdeckt hat, aber nicht, wer gerade die Fußballmeisterschaft gewonnen hat oder welche neuen KI-Entwicklungen gerade die Runde machen. Auch unternehmensspezifische Informationen bleiben außen vor. Ein Standardmodell kann beispielsweise Fragen zu den neuesten BCS-Releases nicht beantworten. Hier kommt RAG (Retrieval-Augmented Generation) ins Spiel. Durch RAG erhält das Sprachmodell Zugriff auf aktuelle oder fachspezifische Informationen. Damit kann die KI nicht nur auf ihr vortrainiertes Wissen zurückgreifen, sondern auch auf die aktuelle Daten, die speziell für die Aufgabenstellung relevant sind.

Was ist Retrieval-Augmented Generation?

Retrieval-Augmented Generation (RAG) ist ein Architekturansatz, der die Leistungsfähigkeit großer Sprachmodelle (LLMs) mit externen Wissensquellen kombiniert. Anstatt sich ausschließlich auf das im Modell gespeicherte Wissen zu verlassen, kann es bei Bedarf zusätzliche Informationen aus einer Datenbank oder Dokumentensammlung abrufen und als Kontext für die Antworterstellung nutzen. Dadurch werden die generierten Antworten präziser, aktueller und auf den jeweiligen Anwendungsbereich zugeschnitten.

Eine Anfrage an das Sprachmodell wird mit RAG in zwei Schritten beantwortet:

| 1. | Abrufphase (Retrieval): Zuerst identifiziert ein sogenanntes Retrieval-Modul kontextrelevante Dokumente oder Textabschnitte aus einer hinterlegten Wissensbasis. |

| 2. | Generierungsphase (Generation): Anschließend werden diese Informationen zusammen mit der ursprünglichen Anfrage an das Sprachmodell übergeben, das daraufhin eine passende Antwort formuliert. |

Über den System-Prompt wird gesteuert, wie das Modell die gefundenen Texte verwendet, also ob es daraus zitiert, sie zusammenfasst oder nur als Hintergrundwissen einbezieht.

Definition: Retrieval-Augmented Generation (RAG)

Retrieval-Augmented Generation (RAG) bezeichnet ein Verfahren, bei dem ein Sprachmodell zusätzlich zu seiner Anfrage automatisch relevante Informationen aus einer externen Wissensquelle abruft und diese in die Antwortgenerierung einbezieht. So entstehen präzisere, aktuellere und kontextbezogene Antworten, ohne dass das Modell neu trainiert werden muss.

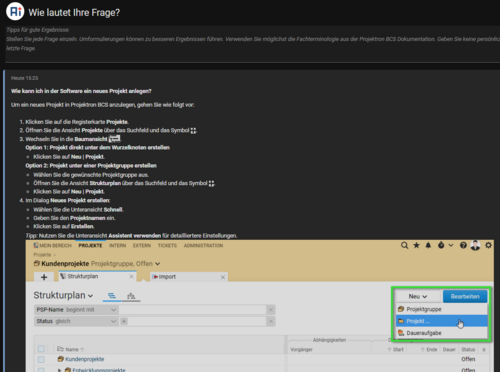

RAG in BCS

In unserer Umsetzung erhält das Sprachmodell zusätzlich zur Nutzerfrage automatisch ausgewählte Texte aus einer gepflegten Datenbank. Diese Dokumente wurden vorab indexiert, damit sie bei Bedarf dynamisch abgerufen werden können. Das Modell nutzt sie als Kontextinformation, um die Antwort gezielt an den jeweiligen Inhalt der Softwarehilfe oder anderer Wissensquellen anzupassen. Ein praktisches Beispiel für den Einsatz ist die Integration von RAG in dieBCS-KI-Hilfe. Hierbei wurde RAG genutzt, um Nutzern präzise Antworten auf spezifische Fragen zu liefern, indem relevante Dokumente aus der Softwarehilfe abgerufen und in die Antwortgenerierung einbezogen wurden.

Abgrenzung und Unterschied RAG vs. klassische Sprachmodelle

Klassische Sprachmodelle basieren auf einem festen Trainingsdatensatz. Ihr Wissen ist auf den Zeitpunkt des letzten Trainings begrenzt. Um ein solches Modell um neues Wissen zu erweitern, kann man ein sogenanntes Finetuning durchführen: Dabei wird das bestehende Modell mit einem kleineren, anwenderspezifischen Datensatz nachtrainiert. Dieses Verfahren ist jedoch aufwendig, ressourcenintensiv und führt nur zu einem neuen statischen Wissensstand. Neue oder geänderte Informationen nach dem Trainingsende sind dem Modell weiterhin unbekannt. Zudem kann Finetuning unbeabsichtigte Nebeneffekte haben, etwa eine Verschlechterung des allgemeinen Sprachverständnisses. Wird eine neue Modellgeneration eingeführt, muss das Finetuning erneut durchgeführt werden.

RAG stellt eine flexiblere Alternative dar: Das Modell bleibt unverändert, kann aber über das Retrieval-Modul jederzeit auf aktuelle oder domänenspezifische Informationen zugreifen. Dadurch entfällt der Trainingsaufwand, und das System kann laufend aktualisierte Inhalte berücksichtigen. Das eigentliche Sprachmodell lässt sich einfach gegen eine leistungsfähigere Version austauschen. In unserer Variante bedeutet das: Nutzer erhalten auf ihre Fragen präzise und aktuelle Antworten, die auf geprüften Texten aus der hinterlegten Datenbank basieren, ohne dass das Sprachmodell selbst neu trainiert werden muss.

Die Vorteile von RAG im Überblick:

Aktualität: Zugriff auf die neuesten Informationen ohne Modellneutrainierung.

Flexibilität: Anpassung an spezifische Domänen oder Wissensbereiche durch gezielten Abruf relevanter Daten.

Effizienz: Vermeidung der Notwendigkeit für umfassendes Finetuning des Modells.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

Wie funktioniert RAG? Die zweistufige Architektur

Retrieval-Augmented Generation (RAG) gehört zu den elegantesten Antworten auf ein Kernproblem moderner KI-Systeme: Wie können Sprachmodelle nicht nur mit ihrem trainierten Wissen arbeiten, sondern auch auf aktuelle, externe Informationen zugreifen? Die Lösung liegt in einer Architektur, die zwei Disziplinen vereint: Retrieval (das gezielte Wiederfinden relevanter Informationen) und Generation (die Erstellung natürlicher, kontextbezogener Texte). Das System arbeitet dabei in zwei getrennten, aber eng miteinander verzahnten Phasen: der Indexierungsphase und der Inferenzphase.

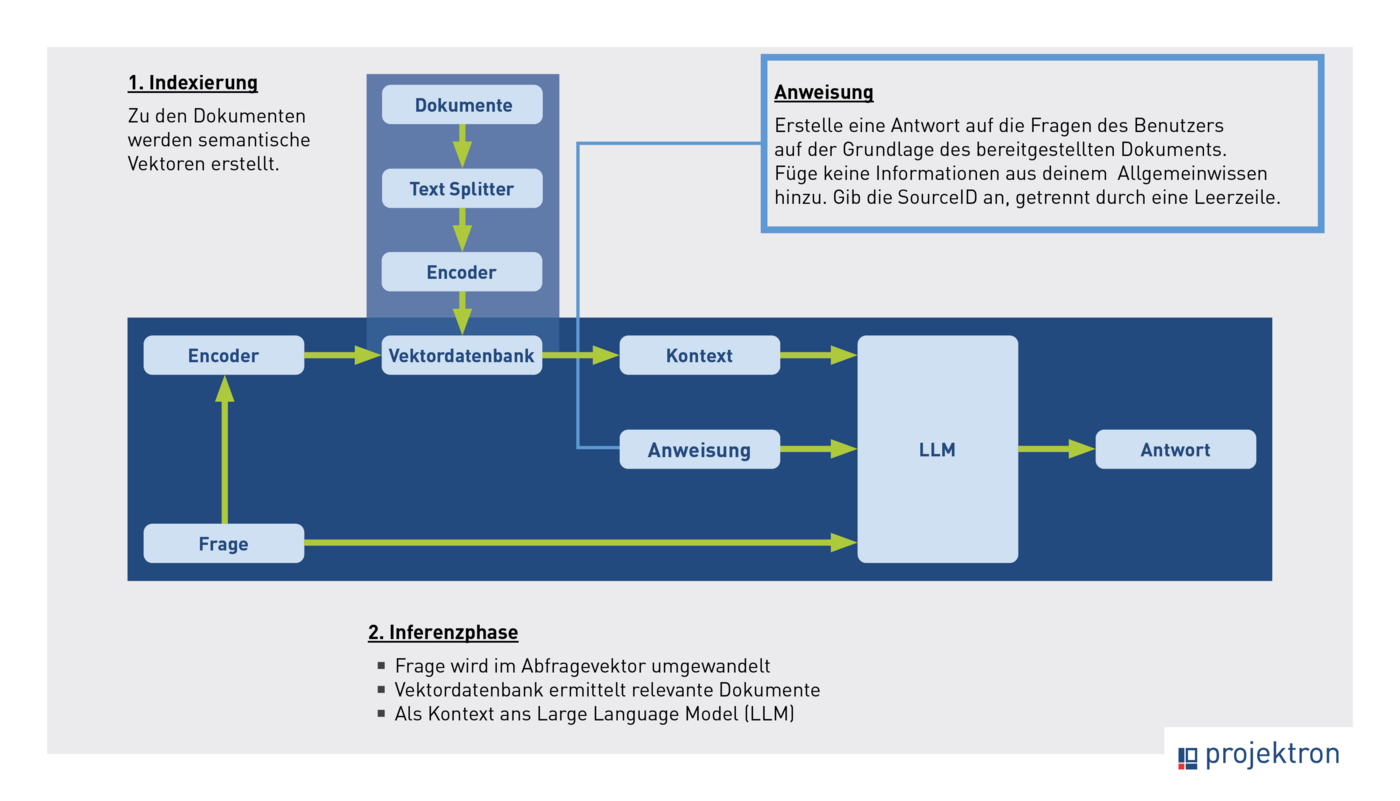

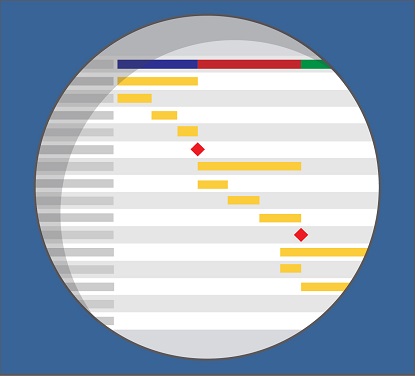

Das Diagramm veranschaulicht den Prozess der Retrieval-Augmented Generation (RAG):

1. Indexierung: Dokumente werden durch einen Encoder in semantische Vektoren umgewandelt und in einer Vektordatenbank gespeichert.

2. Inferenzphase: Eine Frage wird ebenfalls in einen Abfragevektor umgewandelt.

Die Vektordatenbank ermittelt die relevantesten Dokumente, die dann zusammen mit der ursprünglichen Frage und einer Anweisung als Kontext an ein Large Language Model (LLM) gesendet werden.

Das LLM generiert auf dieser Grundlage die endgültige Antwort.

Indexierungsphase: Wissensbasis schaffen

In dieser ersten Phase wird die Grundlage geschaffen, auf der später alle Antworten des RAG-Systems beruhen. Aus den vorhandenen Dokumenten (FAQ, technische Dokumentation oder Forschungsberichte) wird eine strukturierte, durchsuchbare Wissensbasis erzeugt. Bei Projektron besteht der Datensatz beispielsweise aus ca. 2.500 HTML-Dokumenten der BCS-Softwarehilfe. Aus diesen Texten erstellen wir einen Vektorindex, der die semantische Relevanz der einzelnen Textteile abbildet.

Diese Phase lässt sich in drei zentrale Schritte gliedern:

Textaufbereitung

Embedding

Aufbau des Vektorindex

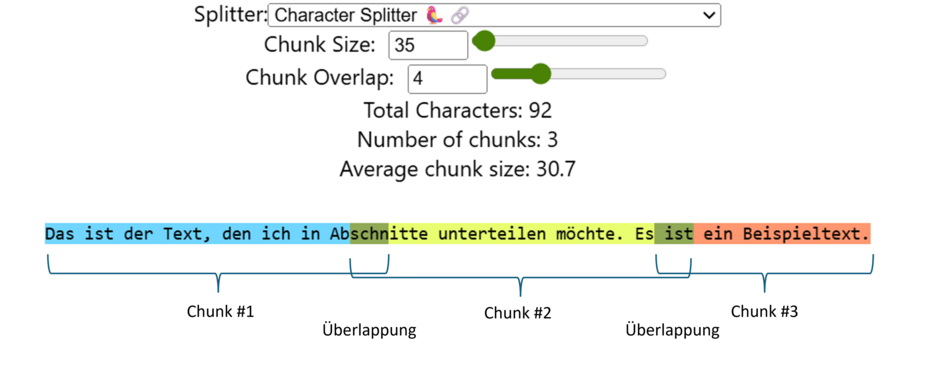

Mit dem ChunkViz v0.1 können Sie die Methode zur Textteilung in "Splits" oder "Chunks", die im Rahmen von Retrieval-Methoden verwendet wird, selbst ausprobieren. Der Screenshot zeigt eine grafische Darstellung, wie ein Text in kleinere Blöcke, sogenannte "Chunks", aufgeteilt wird. Für Texte wie Softwarehilfen, die stark gegliedert und vorstrukturiert sind, kann durch das Erzeugen von Splits konstanter Länge und mit Überlappung eine effektive semantische Kodierung erreicht werden.

- Der Text lautet: "Das ist der Text, den ich in Abschnitte unterteilen möchte. Es ist ein Beispieltext."

- Die Aufteilung der 92 Zeichen erfolgt in 3 Blöcke (Chunks).

- Die "Chunk Size" ist auf 35 Zeichen eingestellt, mit einer Überlappung ("Chunk Overlap") von 4 Zeichen zwischen den Blöcken.

Dieses sogenannte Text Splitting ist ein entscheidender, oft unterschätzter Schritt.

Sind die Splits zu lang, verwässert ihre semantische Bedeutung. Das Modell erkennt dann nicht mehr klar, worum es in dem Textabschnitt eigentlich geht.

Sind sie zu kurz, fehlt der Kontext. Die KI verliert Zusammenhänge und kann kaum sinnvolle Bezüge herstellen.

In der Forschung und Praxis haben sich verschiedene Strategien etabliert:

Rekursives Splitting nach Zeichen oder Absätzen (z. B. bei OpenAI oder LangChain)

Semantisches Splitting anhand von Satzbeziehungen (z. B. Sentence Transformers)

Heuristische Splits mit Überlappung, wie sie etwa in Unternehmensumgebungen oder bei Projektron verwendet werden

Ein Text wie die BCS KI-Hilfe ist semantisch eingegrenzt, stark gegliedert und vorstrukturiert. Rekursives Splitting erzeugt dann viele sehr kurze Chunks, z.B. aus Überschriften und Zwischentiteln, die zu wenig Kontext für das Retrieval mitbringen. Semantisches Splitting scheint in Texten, in denen es nur um ein Thema geht ("wie bediene ich BCS") keine guten Textgrenzen ermitteln zu können.

Bewährt haben sich nach einigen Versuchen Splits konstanter Länge mit leichter Überlappung. Die Länge wird so gewählt, dass jedes Textfragment ausreichend Kontext behält, ohne die semantische Schärfe zu verlieren.

Indexierungsphase Schritt 2: Embedding der Splits: Bedeutung wird zu Mathematik

Nachdem die Texte in handhabbare Einheiten zerlegt wurden, folgt der eigentliche „magische“ Schritt: das Embedding. Dabei wird jeder Textsplit in einen Vektor umgewandelt, also in eine Reihe von Zahlen, die die semantische Bedeutung des Textes repräsentieren.

Diese Vektoren sind keine einfachen Keywords, sondern mehrdimensionale mathematische Abbildungen des Inhalts. Sie ermöglichen, dass das System später semantisch ähnliche Inhalte erkennt, selbst wenn die verwendeten Wörter unterschiedlich sind.

Beispiel:

Die Phrasen„Wie starte ich ein neues Projekt?“ und „Projekt anlegen“ haben zwar kaum gemeinsame Wörter, aber eine sehr ähnliche Bedeutung. Im Vektorraum liegen ihre Embeddings daher dicht beieinander.

Typische Embedding-Modelle sind:

text-embedding-ada-002 vonOpenAI: eines der am weitesten verbreiteten Modelle für semantische Textdarstellung

BAAI/bge-m3: ein lokal installierbares Modell, das Datenschutzanforderungen erfüllt

JINA Embeddings oder Cohere Embed: Alternativen mit starker Performance bei großen Datenmengen

Ein gutes Embedding ist die Basis für präzises Retrieval. Je sauberer die semantischen Beziehungen abgebildet sind, desto besser kann das System relevante Inhalte erkennen.

Indexierungsphase Schritt 3: Aufbau des Vektorindex

Sobald alle Textsplits in Vektoren umgewandelt wurden, werden sie in einer Vektordatenbank gespeichert. Klassische Datenbanken (SQL, NoSQL) sind für solche Aufgaben ungeeignet, da sie keine semantischen Ähnlichkeiten berechnen können. Stattdessen kommen spezialisierte Systeme wie FAISS (Facebook AI Similarity Search), Milvus, Pinecone oder Weaviate zum Einsatz.

Diese Datenbanken sind darauf optimiert, in Milliarden von Vektoren blitzschnell jene zu finden, die einem Suchvektor am ähnlichsten sind, also semantisch am besten passen. Das Ergebnis ist ein Vektorindex, der gewissermaßen das „Gedächtnis“ der RAG-Anwendung bildet.

Mit Abschluss dieser Phase verfügt das System über eine hochgradig organisierte Wissensbasis, die es erlaubt, auf jede Nutzeranfrage gezielt passende Informationen zu finden.

Inferenzphase: Wissen trifft Sprache

Die zweite Phase ist der eigentliche Moment, in dem RAG seine Stärke entfaltet: Das System generiert Antworten.

| 1. | Wenn ein Nutzer eine Frage stellt, wird diese durch dasselbe Embedding-Modell ebenfalls in einen Abfragevektor übersetzt. |

| 2. | Dieser Vektor wird an die Vektordatenbank übergeben, die daraus die semantisch ähnlichsten Textsplits auswählt, also jene Textfragmente, die mit der Frage inhaltlich am stärksten verwandt sind. |

| 3. | Diese Chunks werden dann gemeinsam mit der Frage und einem System-Prompt an das Sprachmodell (z. B. GPT-4, Claude, Mistral oder Llama 3) übergeben. |

| 4. | Der System-Prompt legt fest, wie die KI die bereitgestellten Informationen nutzen soll, also ob sie beispielsweise zitieren, zusammenfassen oder paraphrasieren darf. |

| 5. | Das Sprachmodell kombiniert daraufhin die Kontextinformationen mit seinem allgemeinen Sprachverständnis und erzeugt eine präzise, kohärente und überprüfbare Antwort. |

Praxisbeispiele für RAG

Chatbots und Kundenservice

RAG-basierte Chatbots sind das Rückgrat moderner Self-Service-Portale. Unternehmen wie Microsoft, IBM oder ServiceNow setzen diese Technik ein, um Support-Anfragen automatisch mit dokumentiertem Fachwissen zu beantworten. So kann ein Kunde rund um die Uhr Fragen stellen und erhält Antworten, die auf realen Unternehmensdokumenten basieren, nicht auf Fantasie des Modells.

Bei Microsofts Copilot für Dynamics 365 oder ServiceNow’s Now Assist sorgt RAG beispielsweise dafür, dass Supporttexte, Richtlinien und interne Dokumentationen dynamisch, aktuell und transparent in Antworten einfließen.

Wissensmanagement

Auch im internen Wissensmanagement revolutioniert RAG die Arbeit mit Unternehmenswissen. Mitarbeiter können natürlichsprachlich fragen: „Wie läuft bei uns die Freigabe neuer Software-Releases?“

Das System durchsucht automatisch interne Dokumente, Handbücher und E-Mails, um eine prägnante Antwort zu formulieren, oft inklusive Verweis auf die Originalquelle. Gerade in großen Organisationen mit stetig wachsendem Informationsvolumen schafft RAG hier einen unschätzbaren Vorteil: Wissen wird durchsuchbar, auffindbar und in Echtzeit nutzbar.

Vorteile von RAG gegenüber dem Standalone-Sprachmodell

RAG bietet gegenüber herkömmlichen, rein generativen Sprachmodellen entscheidende Vorteile, insbesondere wenn es um präzise, überprüfbare und aktuelle Antworten auf komplexe Fragestellungen geht. Während ein Standalone-Modell wie GPT oder Llama auf sein statisches Trainingswissen beschränkt ist, erweitert RAG dieses Wissen dynamisch um relevante externe Informationen.

Präzisere und kontextbezogene Antworten

Ohne RAG kann ein Sprachmodell zwar jede Frage beantworten, doch die Antworten basieren ausschließlich auf dem allgemeinen, teils veralteten Trainingskorpus. Die Folge: oft plausible, aber sehr allgemein gehaltene, manchmal inhaltlich falsche oder unvollständige Aussagen.

RAG behebt dieses Problem, indem es gezielt passende Textstellen aus einem definierten Wissensbestand abruft, beispielsweise aus Produktdokumentationen, Handbüchern oder internen FAQs, und dem Modell als Kontext bereitstellt. Dadurch entstehen Antworten, die fachlich fundiert, anwendungsnah und exakt auf die gestellte Frage zugeschnitten sind.

Ein Beispiel: Eine Frage wie „Wie lege ich ein neues Projekt im System an?“ würde ein Standardmodell mit einer allgemeinen Anleitung beantworten. Ein RAG-System hingegen durchsucht die tatsächliche Dokumentation und liefert eine konkrete Schritt-für-Schritt-Erklärung aus dem echten Anwendungskontext plus Screenshot.

Transparenz und Nachvollziehbarkeit

Ein weiterer Vorteil liegt in der Erklärbarkeit der Ergebnisse. RAG kann nicht nur Antworten generieren, sondern auch die Quellen nennen, aus denen die Information stammt. Nutzer sehen auf Wunsch die zugrunde liegenden Dokumente oder Links und können Aussagen direkt im Originalkontext überprüfen. Diese Nachvollziehbarkeit stärkt das Vertrauen in KI-Antworten. Vertrauen ist ein zentraler Punkt, insbesondere in Unternehmensumgebungen, wo fehlerhafte oder intransparente Aussagen erhebliche Konsequenzen haben können.

Einfache Pflege und Aktualisierung

RAG-Systeme sind so konzipiert, dass ihr Wissensstand laufend aktualisiert werden kann. Neue Dokumente lassen sich einfach hinzufügen, veraltete Informationen entfernen. Nach einer erneuten Indexierung, also der Umwandlung der Texte in Embeddings und deren Speicherung in der Vektordatenbank, steht das aktualisierte Wissen für neue Anfragen bereit. Dieser Prozess kann sogar automatisiert erfolgen, z. B. bei regelmäßig erscheinenden Software-Releases oder neuen Produktversionen. So bleibt das System stets aktuell, ohne dass das Sprachmodell selbst neu trainiert werden muss. Das ist ein immenser Effizienzvorteil gegenüber klassischen Finetuning-Verfahren.

Reduzierung von Halluzinationen

Eines der größten Probleme generativer KI ist die sogenannte Halluzination, also das Erfinden scheinbar plausibler, aber falscher Informationen. RAG reduziert dieses Risiko deutlich, weil das Sprachmodell auf reale, geprüfte Texte zugreift. Anstatt frei zu assoziieren, wird die Antwort auf Basis vertrauenswürdiger Quellen generiert, die als Referenz dienen. Damit steigt nicht nur die inhaltliche Qualität, sondern auch die Zuverlässigkeit und Glaubwürdigkeit der KI-Antworten.

Hohe Flexibilität im Unternehmenseinsatz

Da RAG auf strukturierte wie unstrukturierte Daten zugreifen kann, eignet sich das Verfahren für vielfältige Szenarien vom Kundensupport über Vertragsanalysen bis zum Wissensmanagement. Unternehmen profitieren von einer skalierbaren, mehrsprachigen Lösung, die einfach auf neue Anwendungsfelder übertragen werden kann, indem lediglich der zugrundeliegende Datensatz angepasst wird.

Herausforderungen bei der Implementierung von RAG

Trotz seiner Stärken bringt die Implementierung von Retrieval-Augmented Generation auch spezifische Herausforderungen mit sich. Diese liegen weniger in der Modelllogik selbst, sondern in der technischen Feinabstimmung und dem richtigen Umgang mit Daten und Kontextgrößen.

Der Zielkonflikt beim Textsplitting

Ein zentrales Thema ist die Bestimmung der optimalen Länge der Textsplits, also der Textabschnitte, die in Vektoren umgewandelt werden:

Ist ein Split zu lang, enthält er möglicherweise mehrere Themen. Der entstehende Vektor verliert seine Trennschärfe, und relevante Textstellen werden bei der Suche übersehen.

Ist der Split hingegen zu kurz, gehen inhaltliche Zusammenhänge verloren, die für eine sinnvolle Antwort wichtig wären.

In unserer Praxis hat sich gezeigt, dass gleich lange Splits mit leichter Überlappung die besten Ergebnisse liefern. Diese Methode sorgt dafür, dass semantische Beziehungen erhalten bleiben, ohne dass der Vektorraum „verwässert“ wird. Dennoch bleibt die optimale Länge stets abhängig vom Datentyp: Technische Handbücher, juristische Texte oder Chatverläufe erfordern unterschiedliche Strategien.

Den Gesamtzusammenhang erfassen

Eine weitere Herausforderung besteht darin, den Sinnzusammenhang längerer Dokumente zu erhalten. Ein Ansatz hierfür ist das sogenannte Parent-Document-Retrieval: Statt die einzelnen kurzen Splits direkt an das Modell zu übergeben, wird das übergeordnete Elterndokument nachgeladen, aus dem der relevante Split stammt. Dieses Verfahren eignet sich besonders gut für strukturierte Wissensbestände, etwa Handbücher oder Prozessbeschreibungen.

Umgang mit zu spezifischen Begriffen

Ein oft übersehener Stolperstein liegt im Retrieval-Verhalten bei markanten, häufig wiederkehrenden Begriffen. Begriffe wie Produkt- oder Firmennamen (z. B. „BCS“, „Projektron“, „SAP“) werden bei der Vektorsuche stark gewichtet. Wenn jedoch das gesamte Textkorpus diese Begriffe häufig enthält (weil es sich um die Dokumentation handelt), kann die Suche ins Leere laufen: Das System liefert hoch bewertete Treffer, in denen der Produktname mehrfach auftaucht, aber ansonsten mit geringem inhaltlichem Bezug zur eigentlichen Frage.

Eine erprobte Gegenmaßnahme ist die semantische Umschreibung der Nutzerfrage durch eine zusätzliche KI-Abfrage, die überflüssige Eigennamen entfernt und die Nutzerfrage auf den eigentlichen Informationsbedarf fokussiert.

Datenschutz und Sicherheit

RAG-Systeme arbeiten häufig mit sensiblen internen Daten, was besondere Anforderungen an Datenschutz und Informationssicherheit stellt. Wenn externe Cloud-Modelle wie GPT-4 oder Claude eingesetzt werden, dürfen keine personenbezogenen oder vertraulichen Inhalte im Retrieval-Kontext enthalten sein. Zwei etablierte Lösungsansätze sind:

Anonymisierung oder Pseudonymisierung der Dokumente vor dem Einbetten, oder

der Einsatz lokaler Sprach- und Embedding-Modelle, die vollständig innerhalb der Unternehmensinfrastruktur betrieben werden.

Gerade im Enterprise-Kontext ist die kontrollierte Datenhaltung ein entscheidender Erfolgsfaktor. Nur wenn die Quelle der eingebetteten Daten verlässlich, sicher und datenschutzkonform ist, kann RAG sein volles Potenzial entfalten.

RAG bei Projektron – Erfahrungen und Ergebnisse

Die Integration von Retrieval-Augmented Generation (RAG) in produktive Systeme zeigt, wie leistungsfähig dieser Ansatz ist, wenn er richtig umgesetzt wird. Bei realen Projekten, wie bei der Beantwortung technischer Fragen, im Wissensmanagement oder in der Dokumentenrecherche, hat sich RAG als entscheidender Fortschritt gegenüber klassischen Such- oder FAQ-Systemen erwiesen.

Präzisere und kontextbewusste Antworten

Einer der deutlichsten Vorteile liegt in der inhaltlichen Genauigkeit der generierten Antworten. Selbst wenn Nutzerfragen nicht exakt dem Wortlaut der zugrunde liegenden Texte entsprechen oder sich nur auf Teilaspekte beziehen, liefert das RAG-System präzise, nachvollziehbare und vollständige Antworten. Das Modell ist in der Lage, Informationen aus mehreren Quellen sinnvoll zu kombinieren und daraus eine kohärente, gut formulierte Antwort zu generieren statt einfach nur Textstellen zu zitieren.

Ein praktisches Beispiel: Wenn eine Nutzerfrage in einer FAQ-Datenbank auf mehrere verwandte Artikel verweist, erkennt das System automatisch die relevanten Passagen, verdichtet sie zu einem strukturierten Ergebnis und formuliert sie in natürlicher Sprache aus. Das reduziert die Notwendigkeit, den gesamten Originaltext zu durchsuchen, erheblich.

Bessere Struktur und Lesbarkeit

Wenn die Ausgangsdaten nicht besonders sorgfältig editiert wurden, wie es häufig bei FAQ der Fall ist, kann die Ausgabequalität der Antworten nicht nur inhaltlich, sondern auch strukturell überlegen sein. Die generierten Texte sind klar gegliedert, logisch aufgebaut und besser lesbar als die ursprünglichen Dokumente. Das Modell ordnet Instruktionen in einer sinnvollen Reihenfolge an, hebt zentrale Punkte hervor und stellt komplexe Informationen so dar, dass sie auch für weniger spezialisierte Nutzer verständlich bleiben.

Mehrsprachigkeit und Flexibilität

Ein weiterer Vorteil ist die native Mehrsprachigkeit. Antworten können direkt in anderen Sprachen ausgegeben werden, ohne dass separate Übersetzungsschritte nötig sind. Das ist ein entscheidender Effizienzgewinn in internationalen Unternehmen oder bei global eingesetzten Softwaresystemen.

Darüber hinaus ist die Datenbasis flexibel erweiterbar. Neue Wissensquellen lassen sich einfach einbinden, indem sie indexiert und mit passenden Prompts verknüpft werden. Das ermöglicht eine kontinuierliche Aktualisierung des Systems, ohne dass ein zeitaufwändiges Re-Training des Sprachmodells nötig ist.

Übertragbarkeit auf andere Anwendungsfälle

Die gesammelten Erfahrungen zeigen, dass sich die RAG-Architektur leicht auf andere Einsatzszenarien übertragen lässt. Ob Vertragsverhandlungen, interne Wissensdatenbanken oder Supportsysteme, im Kern bleibt der Prozess gleich:

Man stellt den relevanten Datensatz zusammen, definiert ein passendes System-Prompt und kann damit in kürzester Zeit ein kontextsensitives KI-Assistenzsystem aufbauen.

Zukunft mit RAG: Enterprise-KI im nächsten Level

Retrieval-Augmented Generation (RAG) bleibt auch zukünftig für Enterprise-KI-Systeme von Bedeutung. Während sich aktuelle Sprachmodelle rasant durch größere Kontextfenster und verbesserte interne Speichermechanismen weiterentwickeln, bleibt der RAG-Ansatz zentral, um KI-Systeme zielgerichtet, transparent und effizient einzusetzen.

Selbst wenn Modelle künftig Millionen von Tokens im Kontext verarbeiten können, zeigt sich in der Praxis: Ein gezielter, semantisch hochrelevanter Kontext führt zu besseren Ergebnissen als ein massenhaft erweiterter Input. RAG filtert aus riesigen Datenmengen genau jene Informationen vorab heraus, die wirklich relevant sind, und reduziert so Rechenaufwand, Antwortlatenz und Kosten.

Für Unternehmen bedeutet das:

Skalierbarkeit und Kontrolle: Wissensquellen lassen sich modular anbinden, pflegen und versionieren.

Datensouveränität: sensible Informationen bleiben im eigenen System, statt in externe Trainingsdaten zu fließen.

Kosteneffizienz: nur relevante Textausschnitte werden verarbeitet, was die Tokenkosten moderner LLMs drastisch senkt.

Damit etabliert sich RAG als Kernkomponente einer strategischen KI-Architektur, die sowohl Präzision als auch Compliance-Anforderungen berücksichtigt. Für Enterprise-Anwendungen in regulierten Branchen wie IT, Finanzen, Recht oder Projektmanagement ist das ein entscheidender Faktor.

Kombination mit Agenten und Tool-Use

Unser nächster Entwicklungsschritt liegt in der Verzahnung von RAG mit agentenbasierten Frameworks und Tool-Use-Systemen. Agenten-Architekturen wie sie derzeit in der Forschung unter Begriffen wie Autonomous Agents oder Orchestrated AI diskutiert werden, ermöglichen es, KI-Systeme modular aufzubauen: Ein Agent entscheidet selbstständig, welche Tools, Datenquellen oder API-Aufrufe er benötigt, um eine Aufgabe zu lösen. Über die jetzt fest verdrahtete RAG-Abfrage kann dann der KI-Agent entscheiden. Wenn der Nutzer wissen möchte, wie er in BCS seinen Urlaub beantragt, wird der Agent per RAG die Hilfe befragen. Wenn der Nutzer wissen möchte, wie viele Urlaubstage er in diesem Jahr noch hat, wird der Agent per Tool die BCS-Datenbank nach den Urlaubsdaten des Anwenders befragen. In beiden Fällen erhält das Sprachmodell die passenden Kontextinformationen für die Antwort.

Über den Autor

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Hilfe in BCS

Die neue BCS KI-Hilfe bietet seit Version 25.3 präzise Antworten auf Fragen zur Projektron-Dokumentation. Der Artikel zeigt, wie iterative Optimierungen im Retrieval und Splitting die Antwortqualität deutlich verbessert haben.

Auswahl einer PM-Software

Steht in Ihrem KMU oder Ihrem Konzern die Auswahl einer Projektmanagement-Software an, wissen Sie vermutlich gar nicht, wo Sie mit der Suche nach dem für Sie passenden PM-Tool anfangen sollen. Dieser Guide bahnt Ihnen den Weg durch den PM-Software-Markt und führt Sie in 9 Schritten zur richtigen Entscheidung.