08.12.2025 - Fachartikel

Die KI-Hilfe in BCS: Schritt für Schritt zur präzisen Antwortqualität

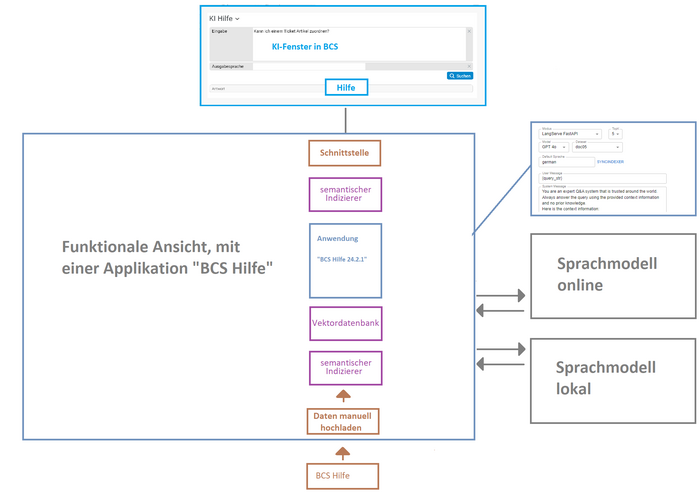

Mit der BCS KI-Hilfe haben wir bei Projektron unsere erste produktive KI-Applikation entwickelt, die Anwendern ermöglicht, schnell und zuverlässig Antworten auf Fragen zur BCS-Dokumentation zu erhalten. Der Weg dahin war iterativ: Mehrere Test- und Verbesserungsrunden haben gezeigt, dass nicht das Sprachmodell selbst, sondern vor allem Retrieval, Splitting und Datenaufbereitung über die Qualität der Antworten entscheiden. Dieser Artikel zeigt, wie wir bei Projektron Schritt für Schritt das System optimiert haben – bis hin zum produktiven Einsatz beim Kunden.

Inhalt

Ausgangspunkt: Das klassische RAG-Setup

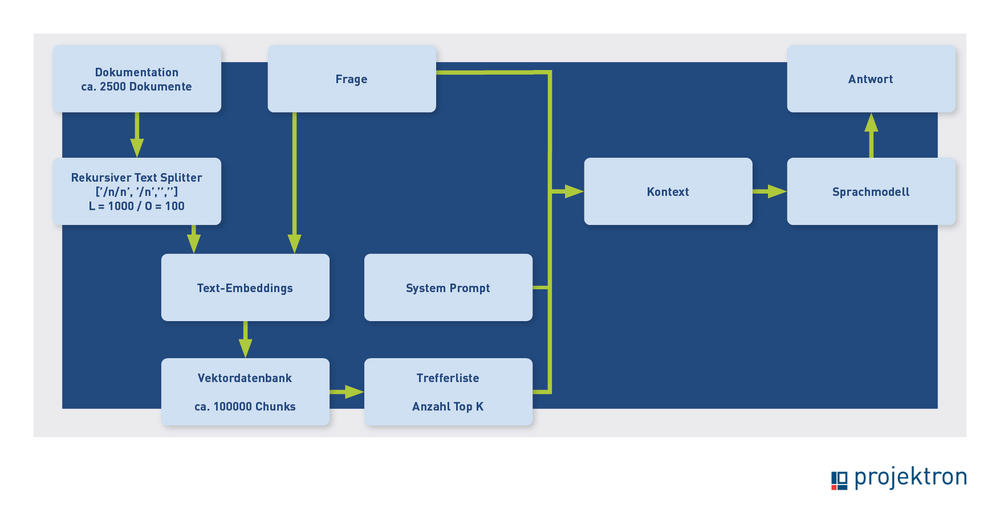

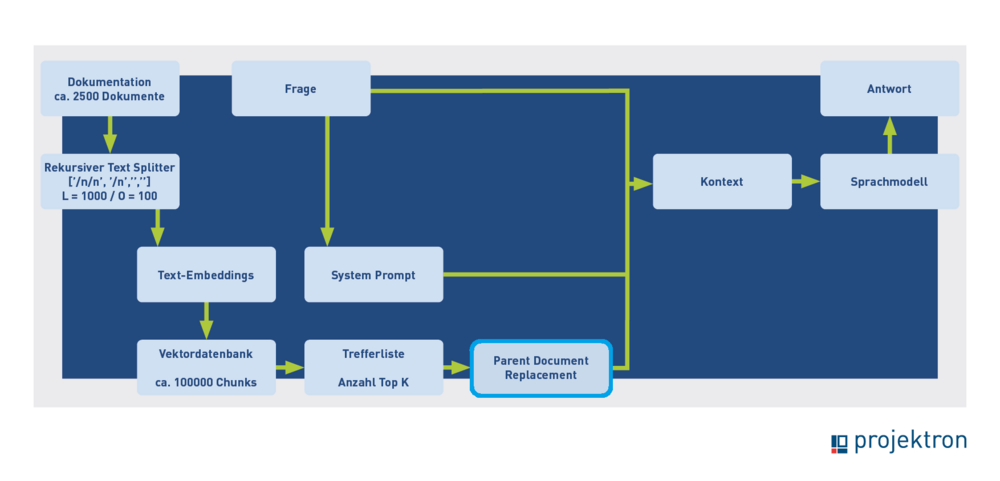

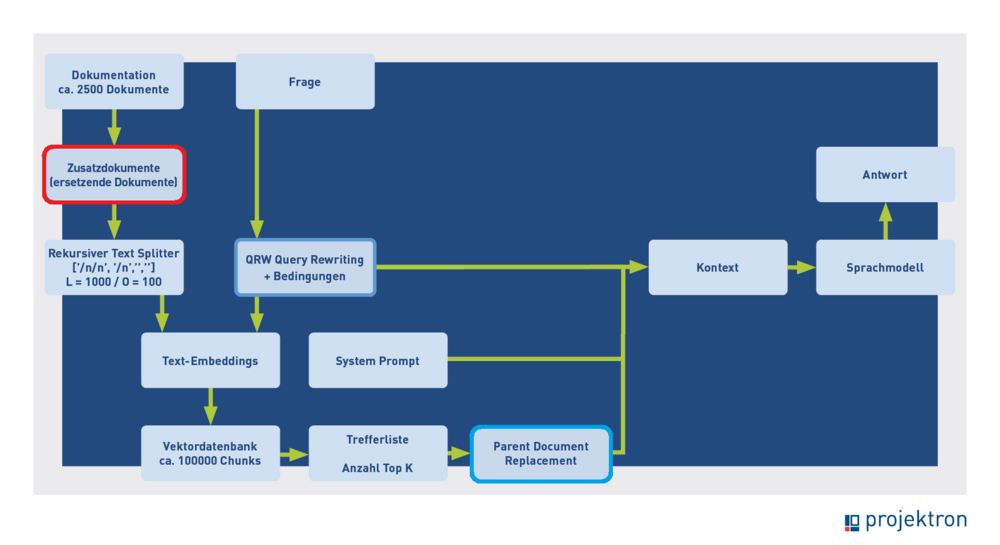

Links in den Bildern ist die Indexierungsphase abgebildet, der Weg von den Dokumenten bis zur Vektordatenbank. Rechts davon die Inferenzphase, der Weg von der Nutzerfrage bis zur Antwort. Nochmal zur Erinnerung: Der Frage wird durch das Text-Embedding ein semantischer Vektor zugeordnet, dann wird die Datenbank nach ähnlichen Vektoren – deren zugehörige Texte also vom gleichen Thema wie die Frage handeln – durchsucht. Die Treffer werden als Kontext an das Sprachmodell übergeben, zusammen mit der Frage und der Anweisung: „Beantworte die Frage anhand der gefundenen Texte“.

Unser erster Aufschlag für die BCS-Hilfe entsprach dem normalen RAG-Schema (Retrieval-Augmented Generation). Den Prozessablauf zeigt das folgende Bild:

Wie findet man heraus, ob dieses Setup gute Ergebnisse liefert? Dazu benötigt man zunächst gute Testdaten. Das sollten validierte Frage-Antwort-Paare sein, sodass man schauen kann, ob die KI zur Frage die vorgegebene Antwort reproduzieren kann. Diese Daten waren bei Projektron in guter Qualität vorhanden, da über den Supportserver von Projektron häufig auch Hilfe-Anfragen gestellt werden. Unsere Testdaten sind also gelöste und vom Kunden abgenommene Hilfe-Tickets aus dem Support.

Wir haben damit gerechnet, dass dieses Fragen im Schnitt eine Nummer zu schwer für die KI sind, also vielleicht zu etwa ein Viertel gut beantwortet werden können, weil nur die geschulten Projektleiter und Administratoren einen Supportzugang haben. Diese Personen sind mit dem System und der Hilfe vertraut und sollten nur solche Fragen kostenpflichtig bearbeiten lassen, die sie mithilfe der Dokumentation nicht selber lösen können. Dieser Schwierigkeitsgrad des Testdatensatzes erschien uns vorteilhaft, da genügend Raum für Optimierungen ist. Ein Vorteil des Datensatzes ist ferner, dass der Test realistisch wird, da wir echte Kundenprobleme (noch einmal) lösen können.

Die Dokumentationsabteilung, als die Experten für die Hilfe, testete die KI-Funktionen. Die Rückmeldungen erfolgten zusammengefasst, in der Regel über Microsoft-Word-Protokolle mit Screenshots und den Beobachtungen. Dann wurden die gefundenen mangelhaften Antworten untersucht, die Gründe ermittelt und überlegt, wie man den Prozess verbessern kann. Die notwendigen Änderungen wurden implementiert und getestet, dann folgte eine neue Evaluationsrunde mit der Dokumentationsabteilung mit dem jetzigen Ergebnis.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

Erster Befund: Kontextverlust im Retrieval

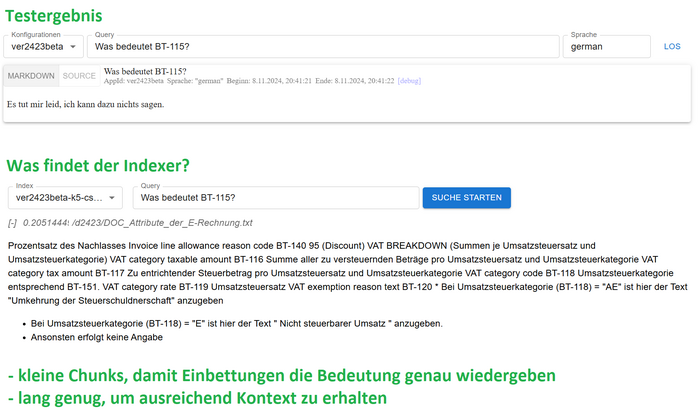

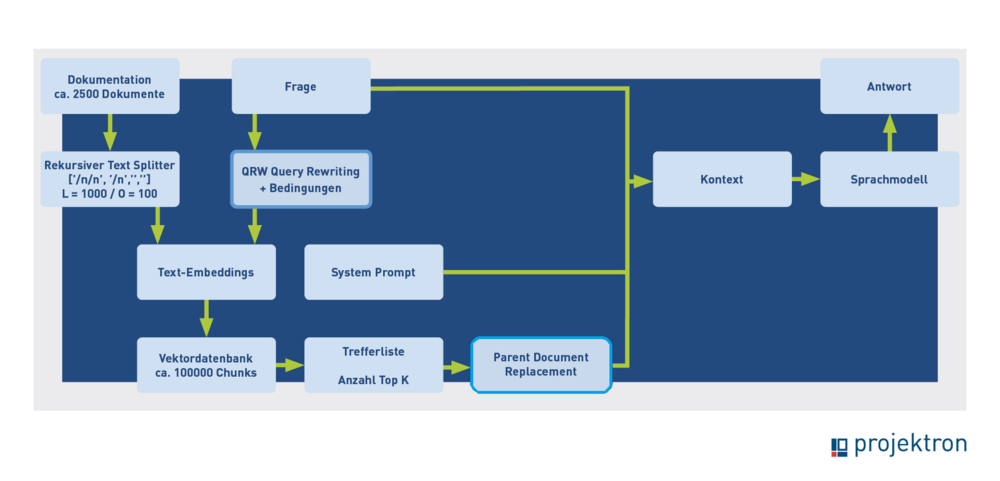

Das folgende beispielhafte Testergebnis aus der ersten Runde führte zu einer Prozessänderung.

Beispiel: die “BT-115-Frage”

Die Frage „Was bedeutet BT-115?“ konnte nicht beantwortet werden, obwohl das in der Dokumentation beschrieben ist. Die BT-Nummern bedeuten „Business Terms“, sie bezeichnen die Felder der elektronischen Rechnung. Die Frage ist schwierig, weil sie keinen Kontext enthält. Wenn man die Frage leicht erweitert, „Was bedeutet BT-115 bei elektronischen Rechnungen“, kommt die richtige Antwort.

Es ist aber auch möglich, die kontextlose Frage richtig zu beantworten. Eine Analyse der Treffer aus der Vektordatenbank ergab, dass ein Textsplitt aus dem richtigen Hilfedokument zur elektronischen Rechnung gefunden wurde, aber nicht derjenige Split, in dem BT 115 vorkam. Mit diesen Informationen kann das Sprachmodell die Frage nicht richtig beantworten.

Lösung: Parent Document Retrieval

Bei der Bestimmung der optimalen Größe der Textsplits besteht ein Zielkonflikt. Einerseits müssen die Splits groß genug sein, um ausreichend Kontext für die Beantwortung der Frage zu liefern, andererseits klein genug, um möglichst nur ein Thema zu enthalten, damit der Vektor die Bedeutung genau wiedergeben kann. Mit „Parent Document Retrieval“ kann man diesen Zielkonflikt zum Teil auflösen.

Die zweite Version des Prozessablaufs, mit Parent Document Retrieval, sah wie folgt aus:

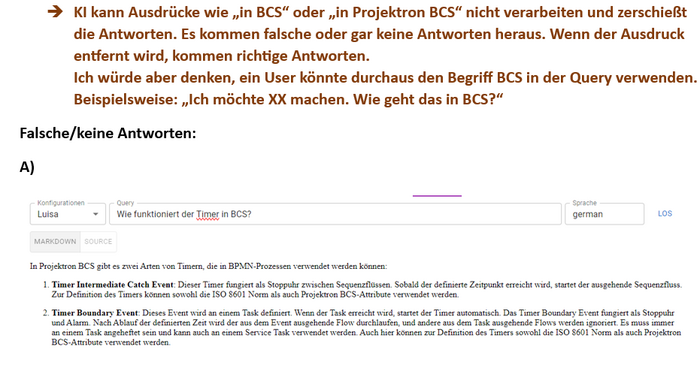

Zweite Testphase: Irrelevante Treffer durch hochgewichtete Begriffe

Die Analyse ergab, dass das Problem auch hier wieder von der Retrieval-Stufe herrührt. Wenn „BCS“ oder „Projektron“ in der Frage enthalten sind, liefert die Vektorsuche oft sehr kurze Textstücke zurück, in denen vor allem „BCS“ oder „Projektron“ steht. Oft hat keiner der fünf Treffer etwas mit dem Rest der Frage zu tun. Auch wenn man den Split durch das ganze Dokument ersetzt, kommt das Sprachmodell mit dieser Kontextinformation nicht zu einer korrekten Antwort.

Verbesserung: Query Rewriting (QRW)

Wenn man in einem allgemeinen Textkorpus suchen würde, ist es eine gute Strategie, sehr spezifische Begriffe wir „BCS“ oder „Projektron“ hoch zu gewichten, um die vermutlich wenigen Dokumente zu finden, die von diesen Themen handeln. Bei unserer speziellen Anwendung handelt aber jeder Text im Korpus von BCS, daher führt eine hohe Aufmerksamkeit für diese Begriffe in die Irre. Wir schreiben deshalb die Frage um, wenn sie bestimmte Begriffe (hier ist der Filter: „BCS“ oder „Projektron“) enthält. Sofern die Begriffe nicht enthalten sind, wird die Frage unverändert verwendet, andernfalls werden die Begriffe von einer KI-Applikation entfernt. Dabei soll die Frage ansonsten möglichst wenig verändert werden. Das ist ein erstes Beispiel für die Verkettung von KI-Applikationen. Der Prozess mit Query Rewriting (QRW) sieht jetzt so aus:

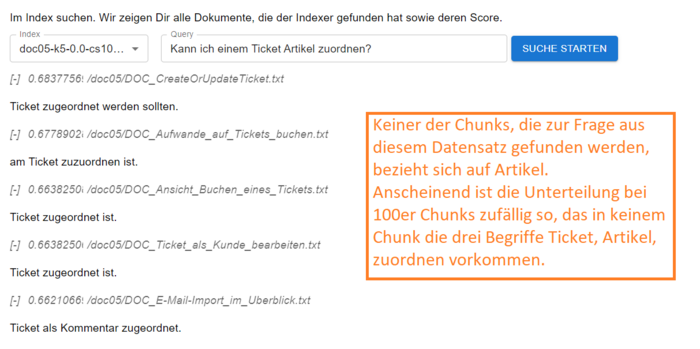

Dritte Testphase: Fehlende Schlüsselbegriffe in kurzen Splits

Damit gehen wir in eine neue Testrunde. Das nächste Fundstück hat wieder mit der Retrieval-Stufe zu tun. Wir haben getestet, ob kürzere Splits, weil sie präziser semantisch vektorisiert werden können, zusammen mit Parent Dokument Retrieval bessere Ergebnisse liefern. Das war überraschend nicht unbedingt der Fall, wie das Beispiel zeigt. Bei größeren Splitlängen (250 oder 1.000 Zeichen) wurde die Testfrage im Beispiel richtig beantwortet, bei einer Länge von 100 Zeichen nicht. Anscheinend gibt es dann zufällig keinen Split, der alle drei bedeutungstragenden Begriffe in der Frage: „Ticket“, „Artikel“, „zuordnen“ enthält. Die Treffer drehen sich meist um die Zuordnung von Mails zu Tickets. Mit diesem Kontextmaterial lässt sich die Frage nicht beantworten.

Lösung: KI-generierte Zusatzdokumente

Als Lösung haben wir implementiert, dass der Datensatz um KI-generierte Zusatzdokumente ergänzt werden kann. In diesem Fall sind das kurze Zusammenfassungen, die alle Schlüsselwörter der betreffenden Hilfeseite enthalten. Die Zusammenfassungen werden nicht weiter gesplittet. Wenn der Indexer eine dieser Zusammenfassungen findet, wird diese wie bei den Textsplits durch die komplette Hilfeseite ersetzt, die dann als Kontext übergeben wird. Damit sieht der Prozess so aus:

Finale Optimierung: Anpassung der Splitting-Strategie

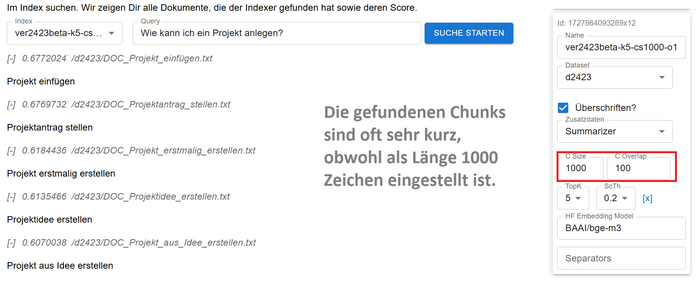

Auch der letzte Verbesserungsschritt, den wir vorstellen möchten, hat mit dem Splitting- und Indizierungsprozess zu tun. Wir haben beobachtet, dass die vom Indexer gefundenen Splits oft sehr kurz sind. In der Standardeinstellung des „Recursive Text Splitter“ wird zuerst an doppelten Zeilenumbrüchen, dann an einfachen, dann an Leerzeichen, und zuletzt im Wort, gesplittet. Da die Hilfedokumente stark strukturiert sind, mit vielen doppelten Zeilenumbrüchen, entstehen viele Splits kürzer als die „Chunk Size“.

Die Standardeinstellung passt gut für Standardtexte, in unserem Spezialfall liefert sie weniger brauchbare Resultate. Das liegt im Effekt daran, dass die semantische Suche diese kurzen Splits sehr bevorzugt. Es ergibt sich oft ein Fundbild wie in der folgenden Abbildung. Obwohl als Splitlänge 1.000 eingestellt ist, sind die gefundenen Splits nur zwischen 16 und 26 Zeichen lang.

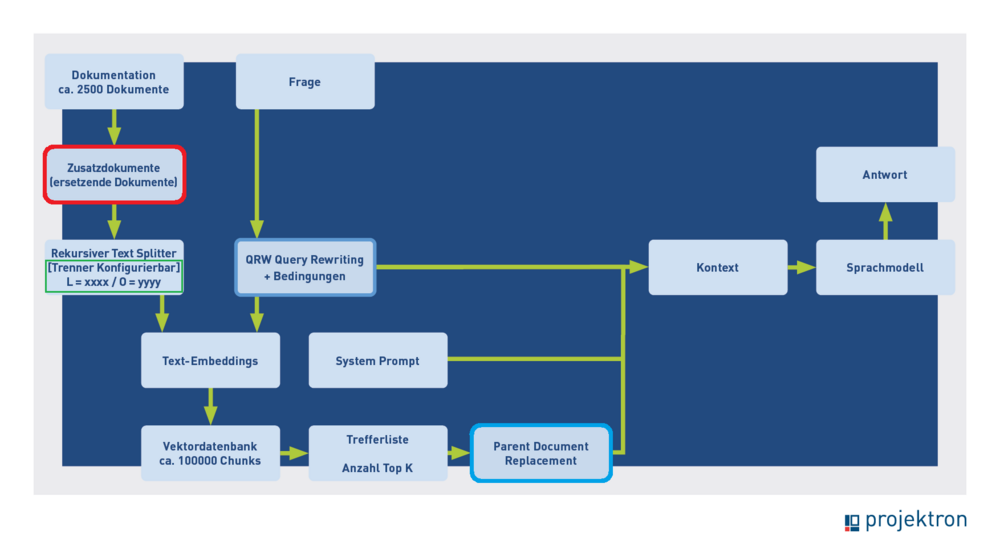

Wir haben den Verdacht, dass (ähnlich wie bei den Begriffen BCS und Projektron) deshalb oft Splits ermittelt werden, die einen hoch bewerteten Begriff enthalten. Das müssen nicht unbedingt die Splits sein, die nach dem Parent Document Replacement auf das optimale Originaldokument führen. Wir haben daher die Splitparameter über das Framework konfigurierbar gemacht, sodass man einfach die fixe Länge einstellen kann, ohne Rücksicht auf Strukturen durch Zeilenumbrüche oder die Semantik. Ein groß gewählter Überlapp sorgt dafür, dass Sinnzusammenhänge möglichst erhalten bleiben. Es scheint nach den Tests, das diese Methode in unserem Spezialfall etwas bessere Ergebnisse liefert als das Standardsplitting. Damit sieht der Gesamtprozess jetzt so aus:

Das ist der Stand, mit dem wir die erste produktive Version der Hilfe ausliefern. Jetzt warten wir auf den „Reality Check“: Erfahrungen mit den ersten echten Kunden.

Man erkennt an unserem Erfahrungsbericht recht gut, dass die meiste Optimierungsarbeit das Retrieval und besonders den Text-Splitter betraf. Wenn man erst einmal den richtigen Kontext ermittelt hat, erstellt das Sprachmodell auch eine passende Antwort.

Von GPT-4o zu Mistral: Gründe für den Modellwechsel

Für die KI-Hilfe hatten wir zunächst GPT-4o verwendet, da es weder Einschränkungen zum Datenschutz noch zur Datensicherheit gab. Wir haben auch mit lokalen Modellen getestet. Auf unserer bisher verwendeten Hardware lieferte Gemma 2 27b (15,6 GB) die besten Ergebnisse. Mit noch größeren Modellen hatte der Testrechner Schwierigkeiten. Die Ergebnisse mit Gemma waren qualitativ recht gut, reichten aber nicht ganz an die von GPT-4o heran. Die Performance war deutlich schlechter, ließe sich durch einen stärkeren Rechner aber verbessern.

Aktuell haben wir uns für Mistral entschieden, das unserer BCS KI-Hilfe als zugrunde liegendes Modell dient. Ausschlaggebend waren vor allem Datenschutz und volle Datenkontrolle. Mistral befolgt die europäischen Datenschutzrichtlinien, was für viele Kunden wichtig ist.

Fazit: Kompakter, kohärenter Text mit Fokus auf Nutzerbenefits

Die Weiterentwicklung der KI-Hilfe in BCS zeigt deutlich, dass nicht das Sprachmodell selbst im Mittelpunkt steht, sondern die Qualität des bereitgestellten Kontexts. Erst durch optimiertes Retrieval, ein auf den Datensatz abgestimmtes Chunking, Parent-Document-Retrieval und ergänzende Zusatzfunktionen liefert die KI heute präzise und konsistente Antworten.

Für die Nutzer bedeutet das vor allem eines: Sie erhalten auf ihre Frage eine direkt passende Antwort – ohne sich erst durch eine Trefferliste kämpfen zu müssen. Früher musste man das richtige Dokument finden und darin die entscheidende Information suchen, was aufgrund der begrenzten Qualität der alten Suche häufig mühsam war. Jetzt übernimmt die KI diesen Schritt und stellt die relevante Information unmittelbar bereit. Das spart Zeit, reduziert Frustration und macht die tägliche Arbeit spürbar effizienter.

Ein kurzer Blick in die Zukunft: Aktuell arbeitet die KI-Hilfe ohne Chatfunktion. Perspektivisch wird es möglich sein, nachzufragen und Antworten weiter zu verfeinern. Damit entwickelt sich die KI-Hilfe von einem nützlichen Werkzeug zu einem verlässlichen Begleiter im Arbeitsalltag, der echte Aufgaben abnimmt und die Nutzung von BCS insgesamt angenehmer und produktiver macht.

Über die Autoren

Maik Dorl ist einer der drei Gründer und bis heute einer der Geschäftsführer der Projektron GmbH. Seit der Gründung im Jahr 2001 prägt er die strategische Ausrichtung des Unternehmens und zeichnet sich heute verantwortlich für die Bereiche Vertrieb, Kundenbetreuung und Produktmanagement. Als Produktmanager ist er die treibende Kraft hinter der Integration innovativer KI-Anwendungen in die ERP- und Projektmanagementsoftware BCS.

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Framework für BCS

Projektron entwickelt ein flexibles KI-Framework für BCS, das vollständig lokal betrieben werden kann und höchste Anforderungen an Präzision, Datenschutz und Transparenz erfüllt. Der Artikel zeigt, welche technischen und organisatorischen Grundlagen das Framework benötigt und wie die Architektur aufgebaut ist.

Vergleich: ERP für Dienstleister

Für Dienstleister entscheidet die Wahl der ERP-Lösung über Effizienz, Transparenz und Umsatz. Unser Vergleich zeigt die 10 besten Systeme, erklärt, welche Funktionen wirklich wichtig sind, und gibt wertvolle Tipps für die Auswahl. Finden Sie jetzt das ERP, das Ihr Unternehmen wirklich voranbringt!