18.11.2025 - Fachartikel

Attention in der KI: Wie Maschinen den Kontext verstehen

In der heutigen Welt der Künstlichen Intelligenz (KI) sind Transformer-Modelle wie BERT, GPT und LaMDA allgegenwärtig. Diese Modelle revolutionieren die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) und ermöglichen Anwendungen von maschineller Übersetzung bis hin zu Chatbots. Doch was genau macht diese Modelle so leistungsfähig? Der Schlüssel liegt im sogenannten Attention-Mechanismus (auf Deutsch auch: Aufmerksamkeitsmechanismus): Er bewertet, welche Wörter im Text für ein bestimmtes Wort besonders wichtig sind, und erzeugt so kontextabhängige Einbettungen (Embeddings). In diesem Artikel erfahren Sie, wie der Attention-Mechanismus mathematisch funktioniert, warum er den Unterschied zu älteren Methoden wie LSTM ausmacht und wo er heute in KI-Systemen eingesetzt wird.

Inhalt

Was bedeutet „Attention“ in neuronalen Netzen?

Attention bezeichnet in neuronalen Netzen die Fähigkeit eines Modells, den Fokus gezielt auf die relevantesten Elemente einer Eingabe zu richten. Anstatt alle Tokens einer Sequenz gleich zu behandeln, lernt das Modell, Gewichte zu vergeben, die bestimmen, welche Informationen für die aktuelle Berechnung besonders wichtig sind.

In einem Satz wie „Die Katze sitzt auf der Matte“ erkennt das Modell beispielsweise, dass das Wort „Matte“ semantisch stärker mit „Katze“ verknüpft ist als mit anderen Wörtern im Satz. Diese Gewichtung ermöglicht es, Abhängigkeiten zwischen Wörtern oder Tokens über unterschiedliche Distanzen hinweg zu erfassen.

Durch diesen Mechanismus entsteht für jedes Wort ein kontextualisiertes Repräsentationsvektor, der nicht nur die isolierte Wortbedeutung, sondern auch die semantische Beziehung zu anderen Tokens innerhalb der Sequenz abbildet. Auf diese Weise kann das neuronale Netz komplexe sprachliche Strukturen verstehen und Kontextinformationen effizient in seine Berechnungen integrieren.

Was ist der Aufmerksamkeitsmechanismus?

Der Aufmerksamkeitsmechanismus (Attention-Mechanismus) ist ein Berechnungsverfahren innerhalb neuronaler Netze, das steuert, wie stark einzelne Eingabenelemente bei der Verarbeitung berücksichtigt werden. Er modelliert Abhängigkeiten zwischen Tokens, indem er jedem Element in einer Sequenz einen Aufmerksamkeitswert zuordnet, der angibt, wie relevant es im aktuellen Kontext ist.

Während klassische Netzarchitekturen, wie zum Beispiel Feedforward- oder rekurrente Netze, alle Eingaben mit gleicher Gewichtung verarbeiten, ermöglicht der Aufmerksamkeitsmechanismus eine dynamische Kontextanpassung: Die Gewichtung wird während der Berechnung gelernt und kann sich je nach Eingabe und Position verändern. Dadurch kann das Modell erkennen, welche Informationen innerhalb einer Sequenz inhaltlich zusammengehören oder sich gegenseitig beeinflussen.

In praktischen Anwendungen führt dieser Mechanismus dazu, dass Systeme sprachliche, visuelle oder semantische Zusammenhänge gezielt hervorheben und interpretieren können. Das macht den Aufmerksamkeitsmechanismus zu einem zentralen Bestandteil moderner Transformer-Modelle – er bildet die Grundlage dafür, dass maschinelles Lernen nicht nur Muster erkennt, sondern Bedeutung im Kontext erfasst.

Alle Blogartikel zum KI-Schwerpunktthema: KI-Wissen (1-4) und KI bei Projektron (5-8)

Schritt für Schritt: Wie funktioniert der Attention-Mechanismus?

Der Attention-Mechanismus innerhalb des Transformer-Modells sorgt dafür, dass jedes Wort (bzw. Token) seine Beziehung zu allen anderen Wörtern einer Sequenz berücksichtigt. Auf diese Weise kann das Modell grammatische, semantische und logische Bezüge herstellen – etwa zwischen einem Subjekt am Satzanfang und einem Verb am Ende. In der Transformer-Architektur sind Encoder (Kodierer) und Decoder durch mehrere Schichten aus Self-Attention bzw Cross-Attention und Feedforward-Netzen verbunden. Diese Schichten verwenden Matrizenoperationen, um Aufmerksamkeitsgewichte zu berechnen. Sie bestimmen also, auf welche Teile der Eingabe sich das Modell fokussiert.

Der Prozess lässt sich in fünf zentrale Schritte gliedern:

1. Vektorisierung der Eingabedaten

Bevor Attention wirken kann, werden Wörter oder Tokens in numerische Repräsentationen überführt. Dazu werden sie mithilfe von Embeddings in Vektoren eines hochdimensionalen Raums transformiert, der semantische Ähnlichkeiten zwischen Wörtern abbildet. Damit das Modell zusätzlich die Reihenfolge der Tokens kennt, werden Positions-Embeddings hinzugefügt. So entsteht für jedes Wort ein eindeutiger, mathematisch verarbeitbarer Vektor, der sowohl Bedeutung als auch Position im Satz repräsentiert.

2. Query, Key, Value (Q, K, V)

Aus jedem Embedding werden durch lineare Transformationen drei neue Vektoren gebildet:

Query (Q) – stellt die „Frage“: Welche Informationen sind für mich relevant?

Key (K) – beschreibt alle Token in der Sequenz: Wann bin ich für andere (und mich selber) wichtig?

Value (V) – enthält die eigentliche semantische Information, die weitergegeben wird, falls das Token als relevant eingestuft wird.

Diese drei Vektoren bilden die Grundlage für die Berechnung der Aufmerksamkeitsgewichte zwischen den Tokens.

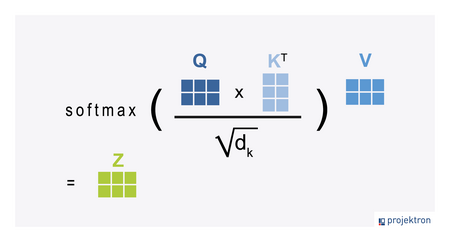

3. Berechnung der Aufmerksamkeitswerte (Attention Scores)

Für jedes Token wird der Query-Vektor mit den Key-Vektoren aller Tokens multipliziert (auch mit dem eigenen Key-Vektor). Das Ergebnis der Multiplikation zeigt an, wie stark zwei Tokens semantisch oder syntaktisch miteinander verknüpft sind. Mathematisch handelt es sich um ein Skalarprodukt: Je höher der resultierende Wert, desto stärker die Beziehung zwischen den Tokens. Aus "handwerklichen" Gründen werden sie durch die Wurzel der Vektordimension geteilt. Das ist der „scaled“-Anteil der Scaled Dot-Product Attention. Im Anschluss wird eine Softmax-Funktion angewendet, die die Summe der Scores auf 1 normiert. So entsteht eine Wahrscheinlichkeitsverteilung, die angibt, wie wichtig jedes Token für das aktuelle Token ist.

Das Bild zeigt die Formel für den "Scaled Dot-Product Attention"-Mechanismus, der ein zentraler Bestandteil des Transformer-Modells ist:

Die Formel berechnet die gewichtete Summe der Werte (V) basierend auf der Ähnlichkeit zwischen den Abfragen (Q) und den Schlüsseln (K).

Die Matrizen Q, K und V werden aus den Eingabedaten erstellt.

Die Division durch dk (die Wurzel aus der Dimension der Schlüssel) dient der Skalierung der Skalarprodukte, um zu verhindern, dass das Softmax-Ergebnis bei großen Werten sehr kleine Gradienten erhält.

Die Softmax-Funktion normalisiert die Skalarprodukte, um eine Wahrscheinlichkeitsverteilung zu erhalten, die die Wichtigkeit jedes Werts (V) für die jeweilige Abfrage (Q) darstellt.

Das Ergebnis Z ist die Ausgabematrix des Aufmerksamkeitsmechanismus.

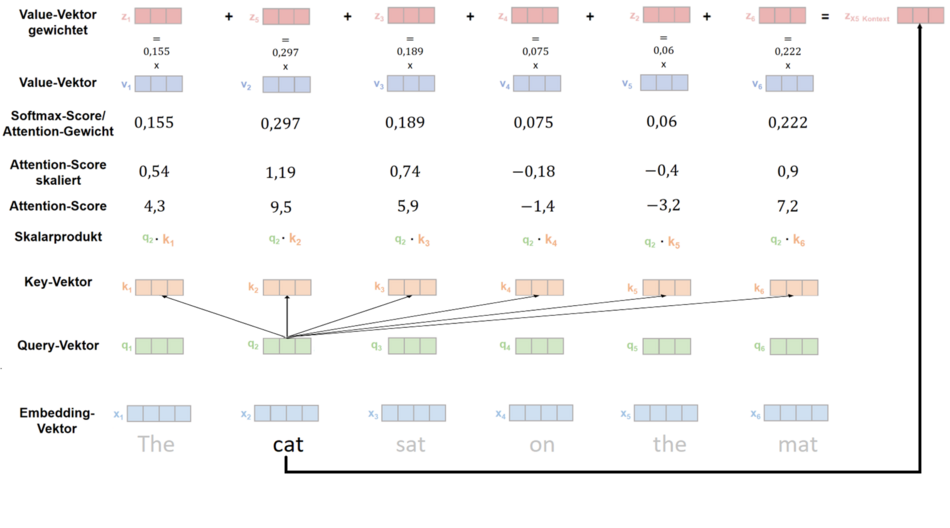

Das Schema oben zeigt die Funktionsweise des Attention-Mechanismus in einem Transformer-Modell, speziell Self-Attention:

Embedding-Vektor (x1 bis x6): Jede Eingabe-Wortsequenz („The cat sat on the mat“) wird zunächst in einen Vektor umgewandelt.

Query-, Key- und Value-Vektoren (q, k, v): Aus den Embeddings werden Query-, Key- und Value-Vektoren gebildet, die für die Berechnung der Attention benötigt werden.

Skalarprodukt (q2·k1, etc.): Der Query-Vektor des aktuellen Wortes (q2 für „cat“) wird mit allen Key-Vektoren multipliziert, um zu messen, wie relevant jedes Wort für „cat“ ist.

Attention-Score: Die Skalarprodukte werden skaliert (meist durch die Wurzel der Vektorgröße) und dann durch Softmax normalisiert, um Attention-Gewichte zu erzeugen.

Value-Vektor gewichtet: Die Attention-Gewichte werden auf die Value-Vektoren angewendet, um den kontextualisierten Vektor (z5 Kontext) zu erzeugen. Das Ergebnis ist eine gewichtete Summe der Value-Vektoren, die das Wort „cat“ im Kontext der gesamten Satzinformation repräsentiert.

Endergebnis: z5 Kontext ist der Kontextvektor für das Wort „cat“, der Informationen aus allen relevanten Wörtern des Satzes integriert.

4. Gewichtete Summe: Kontextgewichtung durch Attention

Die berechneten Aufmerksamkeitsgewichte werden nun auf die entsprechenden Value-Vektoren angewendet. Tokens, die für das aktuelle Wort besonders relevant sind, erhalten höhere Gewichte; weniger relevante tragen weniger bei. Dann werden die gewichteten Vektoren addiert.

Dadurch entsteht ein neuer kontextualisierter Repräsentationsvektor – er beschreibt das Wort nicht isoliert, sondern enthält die wichtigen Bedeutungen der anderen Tokens in der Sequenz.

Beispiel: In den Vektor für„Katze“ fließen durch die gewichtete Vektoraddition Informationen von „sitzt“ und „Matte“ mit ein. Es entsteht sozusagen ein Vektor, der eine auf einer Matte sitzende Katze beschreibt. Das Modell „versteht“ so, dass Katze – sitzt – auf – Matte eine zusammenhängende Bedeutungseinheit bildet.

Dieser Rechenschritt wird für jedes Token ausgeführt.

Der Name Self-Attention bedeutet, das Key-, Querry- und Value-Vektoren aus dem gleichen Text gebildet werden - diese Variante wird verwendet, um einen Text zu "verstehen". Später wird auf Basis des verstandenen Textes (der Nutzereingabe) ein anderer Text, die Antwort, generiert - hier kommt Cross-Attention ins Spiel.

5. Multi-Head Attention (mehrere Perspektiven)

In der Praxis wird die Berechnung nicht mit dem ganzen Vektor durchgeführt, sondern dieser wird vorab in z.B. acht Vektoren von jeweils 1/8 Länge unterteilt. Auch die Query-, Key- und Value-Matrizen gibt es acht Mal - es gibt also acht parallel arbeitende Attention-Heads. Dadurch kann das Modell besser mehrere semantische Ebenen gleichzeitig berücksichtigen und komplexe Beziehungen im Kontext präzise abbilden.

Ein Head kann beispielsweise grammatische Abhängigkeiten (z. B. Subjekt–Verb-Beziehungen) erfassen,

ein anderer Head semantische Zusammenhänge (z. B. Katze – Tier),

ein weiterer Head kausale Strukturen (weil – deshalb) identifizieren.

Die Ergebnisse aller Heads werden konkateniert (zusammengefügt) und durch eine weitere lineare Schicht verarbeitet.

Von diesen Attention-Blöcken werden dann 6 oder mehr übereinander gestapelt, denn in der Praxis zeigen sich dabei bessere Ergebnisse als bei einem Block.

Der Transformer: Attention in Aktion

Der Transformer ist die Architektur, die den Attention-Mechanismus zum Kernprinzip moderner KI gemacht hat. Er bildet die Grundlage für nahezu alle leistungsfähigen Sprachmodelle der Gegenwart, darunter BERT, GPT, T5 oder LaMDA.

Der Transformer besteht aus zwei Hauptkomponenten: einem Encoder (Kodierer), der den Eingabetext analysiert, und einem Decoder (Dekodierer), der daraus eine Ausgabe erzeugt, beispielsweise eine Übersetzung, Zusammenfassung oder Chat-Antwort. Beide Komponenten bestehen aus mehreren identisch aufgebauten Schichten, die Attention-Mechanismen und Feedforward-Netze kombinieren.

a) der Encoder:

Der Encoder verarbeitet die Eingabesequenz, indem er sie in eine Reihe von kontextualisierten Vektoren umwandelt.

Jede Encoder-Schicht enthält eine Multi-Head-Self-Attention-Komponente und ein vorwärtsgerichtetes Feed-Forward-Netzwerk (FFN).

Der Multi-Head-Self-Attention-Teil ermöglicht es dem Encoder, jede Position in der Eingabesequenz zu betrachten und die Relevanz der anderen Positionen zu bewerten.

b) der Decoder

Der Decoder verarbeitet die Ausgabe des Encoders und die bisher erzeugte Ausgabesequenz, um das nächste Element der Ausgabesequenz zu erzeugen.

Jede Decoder-Schicht enthält drei Sub-Schichten: eine maskierte Multi-Head-Self-Attention-Schicht, eine Multi-Head-Cross-Attention-Schicht und ein Feed-Forward-Netzwerk.

Im ersten Decoder-Schritt sagt die "maskierte Self-Attention" das Folgetoken auf Basis der bisher erzeugten Tokenkette voraus. Die Maskierung sorgt dafür, dass das Modell bei der Vorhersage jeweils nur das nächste Token erzeugen kann. Die weiteren folgenden Token sind blockiert.

In der Cross-Attention-Schicht werden die Informationen aus der Eingabesequenz einbezogen. Aus dem Vektor, den die maskierte Self-Attention als nächstes Glied der Antwortkette "vorgeschlagen" hat, entsteht der Querry-Vektor. Key- und Value-Vektoren werden aus der Encoder-Ausgabe erzeugt. Wie in der Darstellung des Encoders geschildert, werden jetzt die Skalarprodukte von Key- und Querry-Vektoren berechnet, mit denen dann die jeweiligen Value-Vektoren gewichtet werden. Am Ende werden alle gewichteten Vektoren addiert und ergeben nach Durchgang durch die letzte "Linear"-Schicht eine Wahrscheinlichkeitsverteilung über alle Token des Vokabulars. Das Token mit der höchsten Wahrscheinlichkeit wird an die Kette angehängt, und der nächste Durchlauf beginnt.

Der Prozess läuft so lange weiter, bis ein spezielles End-of-Sequence-Token (<EOS>) signalisiert: „Abschnitt zu Ende.“

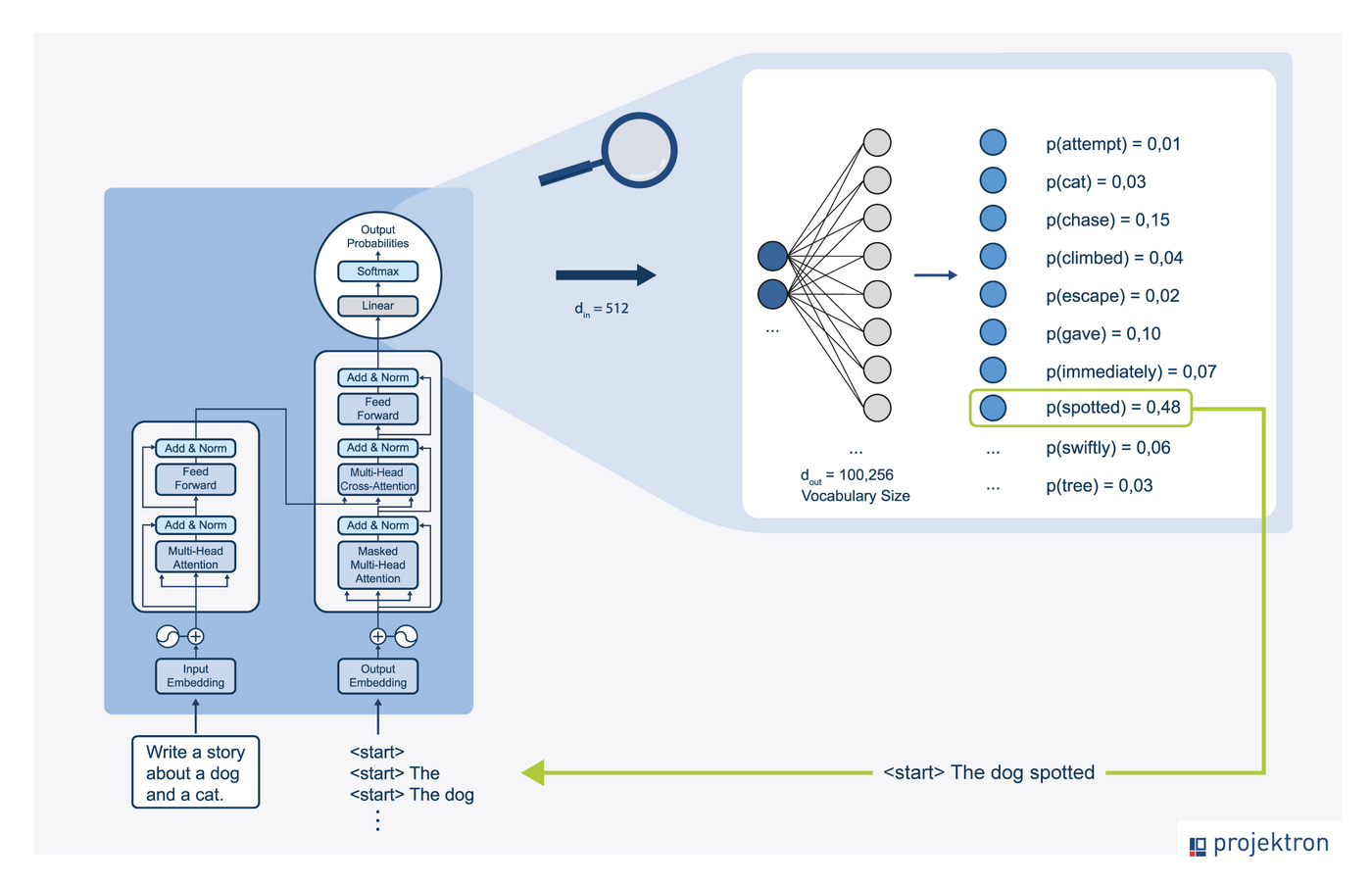

Das Bild zeigt eine schematische Darstellung eines neuronalen Netzes, das zur Generierung von Text verwendet wird. Es handelt sich um ein Transformatormodell, das typischerweise für Aufgaben wie die Sprachübersetzung oder die Textvervollständigung eingesetzt wird:

Das Modell besteht aus einem Encoder-Teil (links) und einem Decoder-Teil (rechts).

Der Encoder verarbeitet die Eingabesequenz ("Write a story about a dog and a cat.") und erstellt eine interne Repräsentation.

Der Decoder generiert auf Basis dieser Repräsentation und der bisher erzeugten Wörter das nächste Wort in der Sequenz.

Die Wahrscheinlichkeiten auf der rechten Seite zeigen, welche Wörter das Modell als Nächstes vorschlägt, um den Satzanfang "The dog" zu vervollständigen. Das Wort "spotted" hat die höchste Wahrscheinlichkeit von 0,48. Es wird an die Kette angehängt.

Die neue Kette wird wieder in den Decoder eingegeben, um das nächste Element zu genereiren.

Der Prozess läuft so lange weiter, bis ein spezielles Element (<eos>, end of sequence) ausgewählt wird. Dieses signalisiert, dass Antwort fertig ist.

Durch die starre Auswahl immer des wahrscheinlichsten Tokens entstehen oft langweilige, repetitive Texte. Manchmal gerät das Sprachmodell sogar in eine Schleife, aus der es nicht herausfindet. Um dieses Problem zu beheben, betrachtet man statt nur des wahrscheinlichsten Tokens eine Auswahl der wahrscheinlichsten Token und "würfelt" eines davon aus. Die Antworten werden dadurch lebendiger. Die Technik wird Sampling genannt.

Über Parameter lassen sich die Auswirkungen steuern, z.B. die Anzahl der wahrscheinlichsten Token, aus denen gewürfelt wird. Über einen Parameter "Temperatur" lassen sich die Wahrscheinlichkeiten nachbearbeiten: hohe Temperatur gleicht die Wahrscheinlichkeiten der Tokenauswahl an – ungewöhnliche Texte werden wahrscheinlicher. Für ein Gedicht wählt man also eine hohe Temperatur, für eine werkgetreue Übersetzung besser eine niedrige.

Mithilfe dieser Sampling-Strategien entsteht schrittweise eine natürlich klingende Textsequenz. Das Ergebnis wirkt für den Nutzer wie ein durchgängiger, bedeutungshaltiger Text, der aber tatsächlich auf einer Folge von Vektoren, Matrizen und gewichteten Wahrscheinlichkeiten basiert.

Warum ist Attention für moderne KI so wichtig?

Der Attention-Mechanismus hat die Landschaft des maschinellen Lernens nachhaltig verändert und bildet das Fundament moderner Deep-Learning-Modelle. Ohne ihn wären Transformer-Modelle wie GPT, BERT, T5 oder PaLM nicht denkbar. Seine Bedeutung beruht auf mehreren entscheidenden Vorteilen:

Besseres Kontextverständnis und höhere Modellleistung: Attention erlaubt es, den gesamten Kontext einer Eingabe gleichzeitig zu berücksichtigen. Dadurch kann das Modell auch bei langen Sequenzen semantische Abhängigkeiten erkennen und konsistente Ergebnisse erzeugen.

Effiziente Parallelisierung: Im Gegensatz zu Recurrent Neural Networks (RNNs), die Eingaben sequenziell verarbeiten, kann der Transformer dank Attention alle Tokens einer Sequenz gleichzeitig berechnen. Diese Parallelisierbarkeit macht das Training hochperformanter Modelle auf modernen GPUs und TPUs überhaupt erst praktikabel.

Verbesserte Interpretierbarkeit: Die Aufmerksamkeitsgewichte sind visualisierbar und geben Einblick, welche Tokens für eine Entscheidung maßgeblich waren. So lassen sich neuronale Entscheidungen nachvollziehen und teilweise erklären, was einen wichtigen Schritt in Richtung Explainable AI (XAI) darstellt.

Architektonische Vielseitigkeit: Attention ist nicht auf Sprache beschränkt. Sie wird in der Computer Vision (z. B. Vision Transformer, ViT), der Spracherkennung, der Musikanalyse und in der Zeitreihenmodellierung erfolgreich eingesetzt. Überall dort, wo Beziehungen zwischen Elementen einer Sequenz oder eines Bildes modelliert werden müssen, liefert Attention überlegene Ergebnisse.

Praxisbeispiele: Wo Attention überall steckt

Maschinelle Übersetzung: Dienste wie DeepL oder Google Translate nutzen Attention, um mehrdeutige Wörter im Kontext korrekt zu interpretieren. So erkennt das Modell, ob das Wort „Bank“ im jeweiligen Satz „Sitzgelegenheit“ oder „Geldinstitut“ bedeutet.

Dialogsysteme und Chatbots: Systeme wie ChatGPT oder KI-gestützte Kundendienstplattformen verwenden Attention, um den Bezug zwischen Nutzerfragen und Kontext zu verstehen. Dadurch können sie kohärente, inhaltlich passende Antworten generieren.

Bildverarbeitung (Computer Vision): Attention-Mechanismen markieren relevante Regionen in einem Bild, beispielsweise Objekte, Tumorstrukturen oder Texturen. In Vision Transformers (ViTs) werden so auch visuelle Beziehungen modelliert.

Sprach- und Audiodatenanalyse: In der automatischen Spracherkennung hilft Attention, zeitlich relevante Passagen zu fokussieren, während in der Musikverarbeitung Muster über mehrere Zeitebenen hinweg erkannt werden.

Web- und Nutzungsanalyse: Moderne Webanwendungen, die KI-Modelle integrieren, verwenden häufig Tracking-Cookies oder lokale Speichermechanismen, um Nutzungsdaten zu erfassen. Diese Daten, wie beispielsweise Geräteinformationen oder Interaktionsverhalten, können in Trainingsprozesse einfließen und dazu beitragen, Modelle kontextsensitiver, effizienter und sicherer zu gestalten.

Fazit: Warum Attention das Herz moderner KI ist

Der Attention-Mechanismus ist das Fundament, auf dem heutige KI-Systeme stehen. Er sorgt dafür, dass Maschinen nicht nur Wörter „sehen“, sondern Bedeutung verstehen, und zwar in einem Umfang, der dem menschlichen Lesen erstaunlich nahekommt. Ob in Übersetzung, Chat oder Textanalyse, Attention ermöglicht den entscheidenden Schritt: vom bloßen Erkennen einzelner Zeichen hin zum Kontextverständnis.

Über den Autor

Dr. Marten Huisinga leitet die teknow GmbH, eine Plattform für Laser-Blechzuschnitte. Künftig sollen KI-Methoden das Angebot für Amateurkunden vereinfachen. Huisinga war einer der drei Gründer und bis 2015 Co-Geschäftsführer der Projektron GmbH, für die er heute beratend tätig ist. Als DPO ist er verantwortlich für die Umsetzung erster KI-Applikationen, um den Nutzen von KI für BCS und die Projektron GmbH zu beurteilen.

Weitere interessante Artikel im Projektron-Blog

Produktmanagement bei Projektron

Wie bleibt eine Software seit 25 Jahren erfolgreich? BCS zeigt: Kontinuierliche Updates, Nutzerfeedback und moderne Technologien sichern langfristigen Erfolg. Erfahren Sie, wie Produktmanagement bei Projektron funktioniert!

Anwendungsfälle KI in BCS

Schritt für Schritt entsteht ein KI-Ökosystem in BCS, das den Arbeitsalltag spürbar erleichtert. Der Artikel zeigt, welche Anwendungsfälle bereits produktiv sind und welche Funktionen noch folgen.

KI-Hilfe in BCS

Die neue BCS KI-Hilfe bietet seit Version 25.3 präzise Antworten auf Fragen zur Projektron-Dokumentation. Der Artikel zeigt, wie iterative Optimierungen im Retrieval und Splitting die Antwortqualität deutlich verbessert haben.

Auswahl einer PM-Software

Steht in Ihrem KMU oder Ihrem Konzern die Auswahl einer Projektmanagement-Software an, wissen Sie vermutlich gar nicht, wo Sie mit der Suche nach dem für Sie passenden PM-Tool anfangen sollen. Dieser Guide bahnt Ihnen den Weg durch den PM-Software-Markt und führt Sie in 9 Schritten zur richtigen Entscheidung.